楊淨 發自 凹非寺量子位 報道 | 公眾號 QbitAI換臉的GAN,還能有啥突破?要不,分析個臉部紋理試試。不得不說,真有點科幻電影的趕腳~這是英偉達最新推出GAN——Alias-Free GAN,號稱

2021-06-30 14:23:23

楊淨 發自 凹非寺量子位 報道 | 公眾號 QbitAI

換臉的GAN,還能有啥突破?

要不,分析個臉部紋理試試。

不得不說,真有點科幻電影的趕腳~

這是英偉達最新推出GAN——Alias-Free GAN,號稱更適合圖片和視訊生成。

尤其是他們之前推出的StyleGAN2相比。

在很多細節上, 比如頭髮、皺紋的轉換、移動都更加順滑。

我仔細看了看,確實如此。

以前的StyleGAN2,就像是某些固定的點粘在螢幕上,然後臉在螢幕下面移動。

而最新的GAN,則是所有細節全都一起移動。

對此,有網友表示,

StyleGAN2出來後,不知道在此基礎上還能有啥突破。結果現在一對比,StyleGAN2更像是拙劣的視訊遊戲特效。

論文詳情

一個典型的GAN是這樣處理臉部細節的。

首先提取一些粗糙、低解析度的特徵,通過上取樣層分層細化。隨後經過卷積層進行局部混合,並經由非線性對映層引入新的細節。

呈現出來的效果就像是,移動頭部導致了鼻子的移動,而鼻子又會移動周圍的面板毛孔。

△StyleGAN2

但這些細節特徵有很強的位置偏好。

也就是說,這些細節特徵每移動到一個位置,都會在那裡停留很久,才移去下一個位置。

依然給人一種不太自然的感覺~

就好比是某個毛孔被固定住了,其他細節繞著它原地摩擦~

用他們的話來說,就是紋理粘連(texture sticking)。

比如StyleGAN2生成的毛髮,大多堅持在相同的座標上,形成了水平的條紋。

本次則主要針對兩種類型的移動——平移和旋轉,Alias-Free-T和Alias-Free-R。

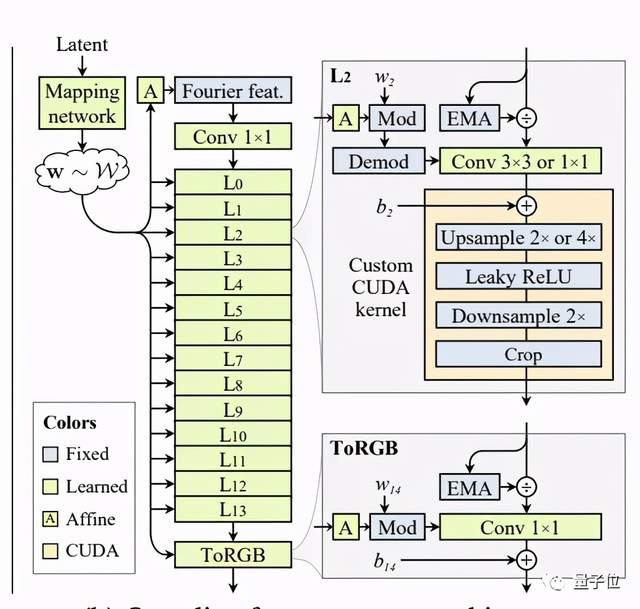

傳統的GAN網路結構,包括卷積、上取樣、下采樣和非線性這幾個方面,而Alias-Free GAN整架構,是在StyleGAN2基礎上調整的。

大致是這樣一個調整過程。

首先,為了便於對輸入的影象進行連續的平移和轉化,他們用傅立葉特徵取代StyleGAN2中的輸入常數。接著,刪除了每個畫素中的噪聲輸入,因為它們與特徵轉換無關。

此外,他們還降低了對映網路的深度,並禁用了混合正則化和路徑長度正則化。最後取消了輸出跳過連線。

在實踐中,還對卷積權重進行了劃分。各層遵循嚴格的2×上取樣時間表,在每個解析度下執行兩層,使得上取樣後特徵圖的數量減半。

結果表明,與StyleGAN2相比,Alias-Free GAN在FID分數上表現的更好。

(FID 用於評估GAN生成影象的質量,分數越低說明影象質量越高)

英偉達出品

一作Tero Karras,可能熟悉StyleGAN系列的看出來了。

這位也是StyleGAN系列的主要開發者。

目前Alias-Free GAN還未開源,GitHub上還沒有任何內容。

研究人員表示,預計9月開源。

論文連結:https://nvlabs-fi-cdn.nvidia.com/alias-free-gan/alias-free-gan-paper.pdf參考連結:[1]https://news.ycombinator.com/item?id=27606347[2]https://nvlabs.github.io/alias-free-gan/[3]https://github.com/NVlabs/alias-free-gan

相關文章

楊淨 發自 凹非寺量子位 報道 | 公眾號 QbitAI換臉的GAN,還能有啥突破?要不,分析個臉部紋理試試。不得不說,真有點科幻電影的趕腳~這是英偉達最新推出GAN——Alias-Free GAN,號稱

2021-06-30 14:23:23

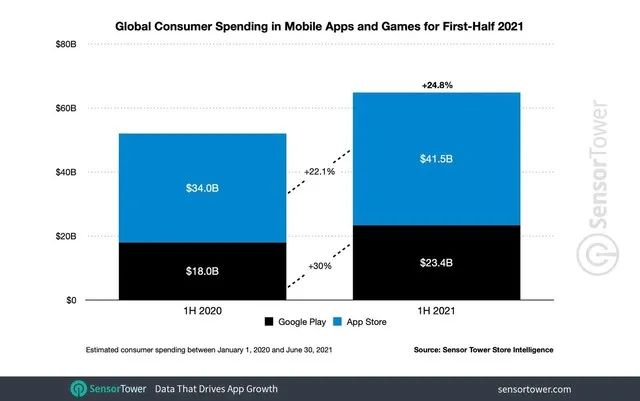

果粉之家,專業蘋果手機技術研究十年!您身邊的蘋果專家~根據移動應用分析機構Sensor Tower的報告顯示,在2021年上半年時間裡,蘋果App Store在全球獲得了415億美元的收入,比2020年

2021-06-30 14:22:54

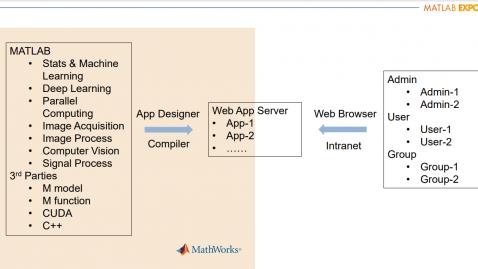

【TechWeb】2021年6月30日,MATLAB EXPO 2021中國使用者大會於6月8日北京舉行。此次大會涵蓋了超過30餘場技術演講和20多個來自MathWorks及其合作伙伴的產品方案展示,內容包括

2021-06-30 14:22:31

#新一代iPhone最快9月底上市#新一代 iPhone模型機首度曝光!不但劉海剪短、鏡頭也變了隨著逼近九月蘋果準備釋出新一代 iPhone,最新推特爆料疑似獲得供應鏈的 CAD設計圖,製作了

2021-06-30 14:03:03

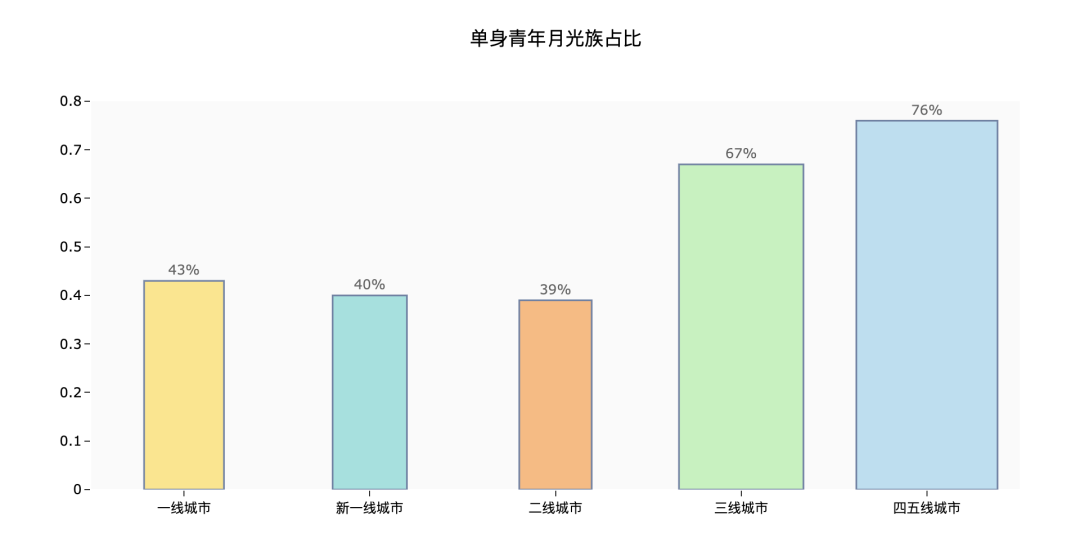

來源:資料STUDIO作者:雲朵君精緻窮?月光族?花錢大手大腳?真實年輕人的消費觀和你想得不一樣!大家好,我是雲朵君!今年上半年最大的電商購物節618終於在熱烈的氛圍中落下了帷幕,但這並

2021-06-30 14:01:26

6月25日,榮耀50系列於榮耀商城、各大授權電商、體驗店等渠道正式開售,首銷當天線上全平臺1分鐘銷售額即破5億,在京東商城更是獲得了高達97%的好評率,可以說是「出道即巔峰」。榮

2021-06-30 14:00:06