列舉從資訊學競賽(OI)或清華計算機系走出來的牛人,人們總會提到鬲融的名字。

這位來自河北唐山的青年,因2004年與樓天城、胡偉棟、慄師代表中國參加第 16 屆國際資訊學競賽(IOI)、全面奪金而一舉成名,保送清華後又在臥虎藏龍的計算機繫留下三項至今無人打破的紀錄:17科滿分、學分積三年排名第一、計算機系歷史最高GPA。

當你以為他只是一位競賽強人時,他向你展示了在文化綜合科上的實力;當你以為他只是「兩耳不聞窗外事,一心只讀聖賢書」的學霸時,他又在離開清華多年後捧回在理論研究上的拔群戰績:NIPS 2016 最佳學生論文獎、素有「諾貝爾風向標」之稱的斯隆研究獎…

然而,關於鬲融的傳說,大多還是集中在早期的競賽與清華姚班的學習上。相比之下,他去普林斯頓讀博、從事理論研究的經歷則鮮為人知。

作為「光環學生」,鬲融的一言一行被寄予厚望。但是,在與鬲融的對話中,我們發現,這位昔日的 IOI 戰神、清華本科特等獎獲得者在科研上並非一帆風順。剛入門時,他也不知道該如何做科研,也是經過一番自我覺醒,才明白了其中的門路。

與競賽、考試相比,鬲融在科研上屬於「大器晚成」:讀博前三年,他在近似演算法研究上探索無果,無奈轉向機器學習理論研究,最後兩年才發了頂會文章。到2019年憑藉非凸優化的研究貢獻獲得斯隆研究獎時,他已是杜克大學計算機系的一名「青椒」。

2008年,鬲融從清華大學本科畢業,隨後赴普林斯頓大學讀博、微軟研究院新英格蘭分部擔任博士後,2015年進入杜克大學擔任教職。從姚班開始立志做理論研究,到成為機器學習理論研究方向小有名氣的青年學者,鬲融用了近 10 年。

那麼,鬲融離開清華後的成長曆程是怎樣的?今天,我們只談鬲融與理論研究之間的故事。

在清華計算機系 4 字班(2004級)中,最出名的當數資訊學競賽圈無人不知的樓天城「樓教主」,百度曾經最年輕的 T10 級員工,後來又率先創立了國內知名的自動駕駛公司小馬智行(Pony.ai)。

許多人最初知道鬲融,是借樓教主的名聲,因為在樓教主的一段軼事裡,鬲融曾作為一個「配角」的身份出現:

當時,樓教主的高中資訊學競賽教練李建江一直認為樓教主是天才型學生,心中引以為豪,每次去北京出差,只要有時間就會順路去清華看望這位得意門生。

結果到了清華,與老師、同學交流,李教練發現,自己的學生在計算機系最多隻能排到第二名,因為樓教主的同班同學鬲融常年排名全年級第一。

他還舉例:每次夜晚 9 點去清華的計算機系宿舍,鬲融肯定在,而樓教主還在教室用功。他因此感嘆,相比鬲融,樓教主是地道的勤奮型選手。

在與AI科技評論的對話中,鬲融首次迴應了這段傳聞:「哈哈其實是因為當時我們宿舍有空調,所以就不用去教室學習,樓天城他們宿舍沒有空調,他只能去教室學習。」

圖注:2007年,鬲融(中間)與樓天城(最左)、胡偉棟(最右)在日本參加ACM/ICPC,獲得亞洲賽區冠軍、全球第二名

樓天城的天賦與能力毋庸置疑,但相形之下,鬲融的實力也可見一斑。然而,在理論研究領域深耕多年後,回頭再看在清華讀本科時的成績與排名,鬲融只是一笑置之,稱自己不過是有一點「考試的天賦」:

我就是在做一些不是特別難的題時可以做得很快,也不太會出錯。考試可能比較有用,但是(這項能力)後來到了研究上面就沒有什麼用了。研究的題比考試難,有些人可能考試時會在一些簡單的題目上卡住,但在做研究的難題時就會做得很快。

鬲融與樓教主曾經是2004年一起參加 IOI 的戰友,上了清華後又曾兩次組隊參加程式設計競賽(兩岸清華程式設計比賽與ACM/ICPC)。但是,與業餘時間還愛「玩玩競賽題」的樓教主相比,鬲融並不「戀戰」,參加完2007年ACM/ICPC後便徹底告別了競賽圈,因為那一年,他找到了下一個人生目標:理論計算機研究。

當時,鬲融剛加入姚班不久。在姚期智、陳衛、孫曉明等人的引導下,尤其是姚期智親自講授《理論計算機》課程,鬲融迷上了理論研究,立志走學術研究道路,將科研作為畢生之所向。

但是,與競賽、做題相比,鬲融的科研「天賦」似乎略微遜色。比如,讀博前期,鬲融在近似演算法(Approximation Algorithm)的研究課題上苦苦折騰了三年,也沒有找到正確的方向,最後只能無奈放棄。

2008年,在姚先生的建議下,鬲融去了普林斯頓大學(計算機理論研究排名全美前5)讀博。普林斯頓的計算機系每年只招收大約 20 名學生。在鬲融那一屆,除了他,還有 3 名中國學生被錄取,包括鬲融昔日的 IOI 戰友慄師(現任紐約州立大學布法羅分校計算機系副教授)。

清華姚班出來的學生對研究往往有一種使命感, 比如,引領一個領域的新潮流,或解決一道歷史上懸難已久的問題。年少的鬲融起初對學術研究也是這樣一種想法:「世界上有那麼多猜想與沒解決的問題,挑一個去做就是了。」

近似演算法的研究歷史可以追溯到18世紀中期尤拉(L.Euler)研究的騎士環遊問題,目標是用近似方法在多項式時間內給出儘可能接近最優值的解,比如著名的「旅行商問題」(TSP):一個商品推銷員要去若干個城市推銷商品,該推銷員從一個城市出發,需要經過所有城市後,回到出發地,那麼,TA 應如何選擇行進路線,以使總的行程最短?

這個課題很吸引鬲融。但很快,他就感到「出師不利」。

近似演算法發展至今,亟待解決的問題是大家都知道的幾個問題,比如旅行商問題、染色問題、最小分割等。鬲融的工作就是研究如何解決這些問題。但是,雖然有明確的研究方向,他卻總會在各種地方卡住,導致工作無法進行下去。

至於卡住的原因,鬲融坦言,他到現在也還不是很清楚:

可能是對研究的課題不熟悉,也可能是思路不對,各種可能都有。我們當時想做的事情直到現在也還沒有人做出來,所以也有可能是因為選擇的題太難。

三年下來,雖然他在ICALP、ISAAC等理論計算機的會議與期刊上發表了論文,但總體感覺還是困難比較多,所取得的成果也遠遠沒有達到鬲融對自己的要求。

回想當時的磕磕絆絆,鬲融分析,做研究無非就是兩方面:一是找到合適的題目,二是把這個題目做出來。在選擇近似演算法時,他對第一步的認知只是在「世界上已有的難題」上,直到後來轉向機器學習理論研究,才發現:原來學會自己定義問題,也是一項可貴的研究能力。

那一年,Hinton與他的學生Alex在ImageNet比賽中憑藉AlexNet遠超第二名10個百分點,勇奪冠軍,深度學習崛起。鬲融的博士導師 Sanjeev Arora敏銳地察覺到機器學習(尤其是深度學習)在未來的發展潛力,開始關注機器學習。

當時,鬲融正在近似演算法的課題上掙扎,這正好給了他重新選擇的契機。剛好他本科在微軟亞研實習時也接觸過機器學習,對這個方向也很感興趣,於是就選擇了轉向研究機器學習理論。

在這裡不得不提的一點是,Sanjeev Arora 在鬲融讀博期間對他產生了重要影響,不僅直接引導他走進了機器學習研究領域,也塑造了他做科研的方法與態度。

Sanjeev Arora是普林斯頓大學計算機系的Charles C. Fitzmorris教授,以研究概率可檢驗證明(尤其是PCP定理)而聞名,1996年獲得斯隆研究獎,2001年與2010年共兩次獲得哥德爾獎(理論計算機領域最高獎),2012年又獲得西蒙斯研究獎與福爾克森獎(離散數學領域最高獎),是理論計算機研究領域有名的翹楚。

鬲融是 Arora 門下的第一個中國留學生。在鬲融來到普林斯頓的前一年(2007年),Arora 與 Satyen Kale(現任谷歌研究科學家)剛剛用乘法權更新演算法(Multiplicative Weight Update Method)的矩陣版本求解了 SDP,並對一些問題給出了更快的近似演算法。MWU 的特點是理論複雜,但演算法簡潔。Arora 在近似演算法上「大道至簡」的追求,吸引了鬲融。

截至目前,Arora 只帶過 3 名中國學生,除了鬲融,其餘 2 位是馬騰宇與李遠志,後來都成為了機器學習領域的佼佼者。馬騰宇與李遠志也是清華大學的校友,分別在2012年、2013年來到普林斯頓讀博,是鬲融日後的重要研究合作者。馬騰宇畢業後到斯坦福大學任教,2021年也憑藉在非凸優化上的研究成果獲得了斯隆研究獎,而李遠志畢業後加入了卡內基梅隆大學機器學習系擔任助理教授。

在鬲融的眼裡,Sanjeev Arora是一位各方面都讓人佩服的學者:

在轉向機器學習之前,他在近似演算法及其複雜度的研究上已獲得非常出色的成就。很多人可能在某個方向上做出成果,就會沿著這個方向繼續做一輩子,但他是一個很喜歡研究新東西的人,喜歡挑戰自己,每隔幾年就會換一個新的方向,然後每個方向都能取得不錯的成就。當時轉向機器學習時,他在第一年或第二年就做出了很好的結果。

也是因為 Arora 的這項品質,他在2012年轉向機器學習研究時,促使鬲融等人也注意到了機器學習,直接改變了鬲融的研究方向。

2012年轉向機器學習時,鬲融已是一名博「四」生,開始一個全新的方向需要極大的勇氣。但他二話不說,重新調整了自己的方向。

出乎意料的是,轉變方向後,他的研究進展異常順利,最後兩年連續發表了 8 篇頂會論文,其中理論計算機頂會 FOCS 就有 2 篇、STOC 有 1 篇,遠遠超過了博士前三年的成果總和。

與近似演算法不同,機器學習是一個相對較新的領域,有許多新的問題。從鬲融的角度來看,這時他的研究問題變成了:如何把一個實際的機器學習問題放到理論的框架裡討論?在這個過程中,「自己定義問題」的重要性明顯上升。

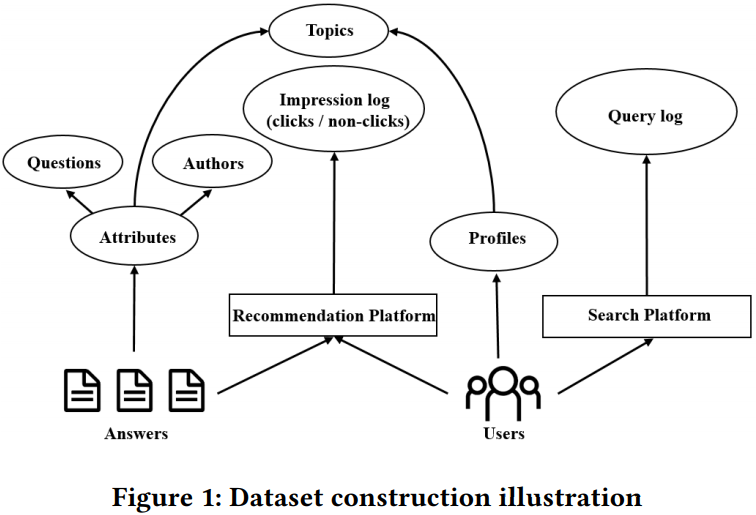

當時,鬲融在微軟研究院新英格蘭分部實習,參與主題建模(Topic Modeling)的研究工作。主題建模被用於對資料(網頁、新聞、圖片等等)進行自動理解與分類,在理論研究上側重於學習模型的參數。

當時的方法大多依賴於奇異值分解(SVD),但SVD方法有兩個限制:要麼假設每篇文章只包含一個主題,要麼只能恢復主題向量的範圍,而非主題向量本身。針對 SVD 用於主題建模的侷限性,鬲融與 Arora 等人提出了一個問題:「如果沒有真正的矩陣 AW ,而是從每一列所代表的分佈中得到一些樣本(比如 100 個樣本),怎麼辦?」

他們假設並證明了 NMF(非負矩陣分解)比 SVD 更適用於主題建模,並利用 NMF 獲得了第一個沒有上述兩個限制的多項式時間演算法,該演算法可以泛化至包含主題與主題相關的模型,比如相關主題模型(Correlated Topic Model)與彈珠機分配模型(Pachinko Allocation Model)。

最後,他們的工作(「Learning Topic Models - Going beyond SVD」 )發表在 FOCS 2012 上。這也是鬲融在 FOCS (理論計算機方向中稿難度最高的會議之一)上發表的第一篇論文。

地址:https://arxiv.org/abs/1204.1956

之後,他又在主題建模的研究上陸續發表了幾篇文章,包括被 ICML 2013 錄取的工作「A Practical Algorithm for Topic Modeling with Provable Guarantees 」,在業內引起不小關注,積累了一點名聲。

在理論研究領域摸爬滾打多年後,鬲融發現:重要的問題並不一定是很多年前就有人提出來的,提出問題本身也是一個重要的研究方向;在做研究時,如果一個問題進展不順,不一定是你的研究技術不對,也有可能是你提的問題本身就是錯的。

這也是鬲融在讀博期間的主要收穫:對研究形成了一個比較完整的認知,並學會了如何選擇一個適合自己的題目。

鬲融能夠「守得雲開見月明」的另一個重要因素是堅持。而這一品質,也主要是受到 Arora 的影響。

鬲融回憶,在讀PhD時,他在研究問題上卡住時,雖然會花時間去想,但經常會有一種感覺,就是「這個想法好像不行,做不下去」,便想放棄。在每週的組會上,他與 Arora 討論卡住的點,說不知道該怎麼做時,Arora 都會說:「這只是一點困難,你可以換一個思路,嘗試別的解決方法。」

「如果要放棄正在進行的方向,就要給出嚴謹的證明,讓 Arora 相信這個方向確實做不了。但是,只要沒有證明這個方向不行,他就不會放棄,會不停地想各種解決辦法。」鬲融形容,「在這種精神下,後來我也確實解決了一些卡住的問題。」

大約是受到 Arora 的鼓舞,鬲融漸漸懂得了堅持,面對難題時也會樂觀許多,更傾向於覺得「這個課題是可以做的」而不是「這個想法好像不行」,即使題目暫時沒有做出來,也不會輕易放棄,而是堅持到實在做不下去的時候。

他感嘆:「如果當時我一說某個思路有哪些困難、覺得做不下去,Arora 就說我們不做這個題了,那麼現在的結果肯定會不一樣。」

但是,儘管最後兩年發表了一些論文,與競賽、本科時的輝煌成績相比,鬲融的博士生涯還是相對黯淡:沒有大廠獎學金,沒有最佳論文。換作旁人,博士期間能在理論計算機頂會 FOCS 與 STOC 上發表3篇工作,已經非常了不起,但對這位清華特獎獲得者來說,總覺得還缺點什麼。

鬲融在2013年獲得博士學位。當時,他剛剛在機器學習理論的酒席上喝到微醺,意猶未盡,「感覺還有很多事情想做」,於是就決定去之前實習的微軟研究院新英格蘭分部做博士後。

也是在兩年的博士後期間,鬲融開始了在非凸優化(Non-Convex Optimization)方向的研究,為之後獲得斯隆研究獎打下了基礎。

在他還是一名實習生時,微軟內部就有人在研究用張量分解(Tensor decompositions)做話題建模。他們的技術非常神奇,就是用兩個矩陣乘一下,然後做一下對角化就能得出成果,光看論文字身完全不明白為什麼這麼做會有用。鬲融就很好奇:「為什麼張量分解這麼厲害?我不知道有什麼理由,所以我就想去研究。」

於是,他們嘗試用張量分解來研究話題模型上的參數問題,發現張量分解不僅可以用於解釋話題模型的參數問題,還可以解釋與話題模型類似的機器學習模型的參數問題。他們的工作「Tensor decompositions for learning latent variable models」最後發表在了機器學習頂刊 JMLR上。

地址:https://arxiv.org/abs/1210.7559

他們在這方面做了很多工作,也取得了不錯的成果,但用鬲融的話說,就是「做多了,也就沒那麼有意思了」。所以,到了博士後階段,他就開始尋找新的方向。

他從張量分解出發,無意間發現了一個新的研究課題,就是非凸優化(non-convex optimization)。

當時,他發現在張量分解的演算法中,比如張量有10個部分,當時的演算法是一個部分、一個部分地找,但有時候,我們會想同時找出這10個部分,這時就需要用到優化技術。那時大家常用的隨機梯度下降優化方法並不管用,於是他就花了很長時間研究如何轉換一個目標函數,可以使它的效果更好。

鬲融回憶:「可能是運氣比較好,在尋找、測試目標函數時,我首先找到了一個目標函數,使得這個優化方法可以把所有的張量部分同時找出來。分析隨機梯度下降的時候,我們研究出了一套新的分析方法,後來發現這套分析方法非常有用,不止對我們研究的張量分解問題有用,對許多其他問題也有用。」

接著,他與袁洋、金馳、黃芙蓉等人沿著這個方向繼續研究非凸優化的函數。

在許多情況下,非凸函數的目標是找到一個合理的局部最小值,主要的問題是梯度更新被困在鞍點(saddle points)中。他們嘗試辨析非凸優化問題的鞍點性質(如果函數沒有退化的鞍點,那麼對梯度做輕微的擾動就可以逃出鞍點),以進行有效優化。利用這個屬性,他們發現隨機梯度下降可以在多項式迭代中收斂到局部最小值。

這是第一項為在具有多個局部最小值和鞍點的非凸函數中的隨機梯度下降提供全局收斂保證的工作。他們的工作開拓了一個新的研究方向,其成果「Escaping From Saddle Points --- Online Stochastic Gradient for Tensor Decomposition」被機器學習理論會議 COLT 2015 收錄,吸引了許多人往這個方向努力,並獲得了許多新的結果。

地址:https://arxiv.org/abs/1503.02101

這是鬲融沒有想到的:「我感覺還是挺幸運的,我從一個非常特殊的問題出發,但是我們最後得到的結論是非常廣泛的,研究也受到不少重視。」

這項工作對機器學習理論研究領域的貢獻主要有兩個:一是證明了張量分析中他新提出來的目標函數有一些好的性質,比如它沒有壞的局部最優解,它的鞍點也有一些性質;二是證明了我們可以用很簡單的演算法(如梯度下降)來優化所有具備這種性質的目標函數。

也是憑藉這兩個主要貢獻,鬲融在2019年獲得斯隆研究獎。

後來,他又分別在這兩個貢獻上作了進一步的研究。比如,在第一個貢獻上,他們後來證明更多函數都具備類似性質,包括與馬騰宇、Jason Lee等人合作的那篇工作「Matrix Completion has No Supurious Local Minimum」(獲 NIPS 2016 最佳學生論文)也證明矩陣補全(matrix completion)沒有壞的局部最優解。

據說,鬲融與馬騰宇合作的這篇工作從開始構思到完成投稿,前後只用了不到兩個月時間。那時 COLT 2015 的工作剛發表不久,可以借鑑一二。鬲融回憶:「當時做的時候,我們就很有信心,因為我們三個人都覺得這個東西肯定是對的。馬騰宇也很快就有了一些具體的想法,我們按照一些步驟去做,然後挺順利地就做出來了。」

至此,鬲融已成為研究用非凸優化尋找最優神經網路參數的早期開拓者之一。但是,在2019年獲得斯隆研究獎後,鬲融又像2004年拿到IOI金牌一樣,若無其事地回到了原本的生活軌跡上,做一名安安靜靜做研究的教師。

斯隆研究獎每年表彰一次,在以往的獲獎人員中,有47人後來獲得諾貝爾獎、17人獲得菲爾茲數學獎、69位獲得國家科學獎、18位獲得約翰貝茨克拉克經濟學獎。史上許多著名的科學家都曾獲得斯隆研究獎,包括物理學家理查德·費曼 ,默裡·蓋爾曼,以及博弈論學家約翰·納什。

從2008年清華畢業,到獲得斯隆研究獎,鬲融用了 10 年。在這期間,他在 4 字班的許多同學(如樓天城、貝小輝)都已早早在新的領域聲名鵲起,但人們談起鬲融,仍只是圍繞競賽與GPA。

雖然鬲融在中途沉寂了很長時間,但在姚班創始人、中國首點陣圖靈獎得主姚期智姚先生的心中,他的名字一直是姚班教育的驕傲。在2017年鬲融還沒有獲得斯隆研究獎時,姚先生談起姚班教育,首先就提到了他的名字:

在學界的,我們有好幾個做人工智慧的學生,已經在大學任教的有兩個,一個是在美國的杜克大學,一個是在美國的斯坦福大學做教授,他們都從事人工智慧理論基礎方面的工作。他們在過去的四五年,在人工智慧理論方面已經非常非常出色……他們確實可以說在人工智慧領域是先驅,將來一定會在該領域留下非常深刻的痕跡。

其中,在杜克大學任教的便是鬲融,而在斯坦福任教的則是鬲融的同門師弟馬騰宇。聽聞姚先生的掛念,當時離開清華多年的鬲融心中感觸萬分:「我感覺挺感動的,因為姚班出來很多很強的人,遠遠不止我們兩個。」

圖注:2019年,鬲融回清華交叉資訊研究院(即「姚班」)作學術報告

在鬲融的成長路上,姚班的身影其實從未遠離。他提到,之前在姚班所學習的知識、思路,一開始不知道有什麼用,但後來都用上了,甚至後悔「當初怎麼不多學點」。而曾經的同窗好友雖然選擇了不同的人生方向,「但想到大家跟我一樣都在努力,就覺得蠻開心的。」

「對我個人來說,如果我知道一個演算法,但是我不知道它的工作原理,是一件不太高興的事情,所以我自己主要就是因為好奇才選擇做機器學習理論研究。」問及從事理論研究的意義,鬲融這樣談道。

而從整個機器學習領域的發展來看,理論機器學習的研究主要有兩個意義:

一是如果知道神經網路演算法的工作原理,我們就有希望解決一些問題,比如讓它變得更快,或者用更少的資源;二是可以解決人們關心的一些實際問題,比如計算機視覺中神經網路的弱關性問題,把一張圖片錯誤識別為其他圖片。

在深度學習時代,機器學習演算法嘗試從文字、影象等資料中自動學習有用的隱含表示。近年來,鬲融的研究重點是希望通過非凸優化與張量分解研究如何設計高效的演算法找到這些隱含表示,比如神經網路模型中的超參數化。

目前的一個觀點是:有了超參數化後,優化會變得簡單。有些工作也得到了同樣的結果,但還有很多問題是未知的,比如:神經網路要多大,才能有足夠好的優化性質?有些觀點認為神經網路要無窮寬,鬲融團隊的研究課題則是:你的神經網路不需要無窮寬,只要足夠寬就可以證明一些類似的性質。

他們最近做了一個工作(「Guarantees for Tuning the Step Size using a Learning-to-Learn Approach」),從理論角度研究如何通過機器學習方法來設計新的優化演算法,得出了一個有意思的結論:對於優化問題,如果你用最基本的back-propagation(反向傳播)方法來算,它的梯度可能會算不準,如果用其他的方式算,可能還可以算得更精確一些。

在未來,他希望能夠進一步瞭解神經網路的優化性質,然後,在掌握足夠多的性質後,可以設計出更好的演算法。

對於想要從事理論研究的學生,鬲融的建議是最好先加入一個研究組去做具體的項目,一是看自己適不適合,二是對機器學習領域的發展有更具體的瞭解,日後做研究時能更好地定義研究問題。

作為最早進入機器學習領域的研究者之一,鬲融能明顯感覺到近幾年來該領域的飛快發展,論文投稿數量呈指數級增長,給人一種浮躁的感覺。由於很難找到足夠多的、有經驗的審稿人來支援大規模的會議投稿,導致會議論文的結果有些隨機。

面對這一現象,鬲融感嘆他也難有作為,只能對自己和自己的學生有一個基本要求,就是投出去的論文至少要達到自己滿意的標準。

隨即,鬲融又說:「雖然我對文章的要求嚴格,但在擔任審稿人時,我感覺自己給分還是偏高的。」

所謂「取其上者得其中,取其中者得其下」,鬲融在非凸優化與張量分解上的研究成就看似偶然,追溯根源,其實在於他對自己做研究的高要求:對好奇的問題刨根問底,對完成的工作精益求精,耐心、敏銳又謙遜,則成事只在時日長短。

科研前期的艱難探索也許是必經之路,即使智如鬲融也不例外。讀博三年還沒有「像樣」的成果?別慌,堅持一下,說不定你也能拿斯隆研究獎。

作者注:人物/採訪、交流、爆料、擡槓,歡迎新增微信(302703941)。