機器之心專欄作者:紫冬君中國科學院自動化研究所日前,中科院自動化所提出了全球首個圖文音(視覺-文字-語音)三模態預訓練模型(OPT-Omni-Perception pre-Trainer),同時具備跨模態理

2021-07-11 03:03:17

機器之心專欄

作者:紫冬君

中國科學院自動化研究所

日前,中科院自動化所提出了全球首個圖文音(視覺-文字-語音)三模態預訓練模型(OPT-Omni-Perception pre-Trainer),同時具備跨模態理解與跨模態生成能力,取得了預訓練模型突破性進展。

自GPT/Bert模型提出後,預訓練模型迎來了爆發式發展。多模態預訓練模型被廣泛認為是從限定領域的弱人工智慧邁向通用人工智慧的路徑探索,其具有在無監督情況下自動學習不同任務、並快速遷移到不同領域資料的強大能力。

近年來,網際網路音視訊資料呈高速增長,佔比超過80% [1],純文字的預訓練模型只涵蓋了網際網路資料中的較少部分,更豐富的語音、影象、視訊等資料並未被充分利用與學習,且人類的資訊獲取、環境感知、知識學習與表達,都是通過多模態資訊方式來執行的。OpenAI 聯合創始人、首席科學家 Ilya Sutskever 在推特上發文表示,「人工智慧的長期目標是構建多模態神經網路,即AI能夠學習不同模態之間的概念,從而更好地理解世界」。為實現更加通用的人工智慧模型,預訓練模型必然由單模態往多模態方向發展,將文字、語音、影象、視訊等多模態內容聯合起來進行學習。自動化所瞄準這一方向,成功構建視覺-文字-語音三模態預訓練模型。

目前,已有的多模態預訓練模型通常僅考慮兩個模態(如影象和文字,或者視訊和文字),忽視了周圍環境中普遍存在的語音資訊,並且模型極少兼具理解與生成能力,難以在生成任務與理解類任務中同時取得良好表現。

針對這些問題,自動化所此次提出的視覺-文字-語音三模態預訓練模型採用分別基於詞條級別(Token-level)、模態級別(Modality-level)以及樣本級別(Sample-level)的多層次、多工子監督學習框架,更關注圖-文-音三模態資料之間的關聯特性以及跨模態轉換問題,對更廣泛、更多樣的下游任務提供模型基礎支撐。

該模型不僅可實現跨模態理解(比如影象識別、語音識別等任務),也能完成跨模態生成(比如從文字生成影象、從影象生成文字、語音生成影象等任務)。靈活的自監督學習框架可同時支援三種或任兩種模態弱關聯資料進行預訓練,有效降低了多模態資料收集與清洗成本。

引入語音模態後的多模態預訓練模型,可以突破性地直接實現三模態的統一表示,特別地首次實現了「以圖生音」和「以音生圖」,如下方視訊所示:

以圖生音示例

以音生圖示例

三模態預訓練模型基本原理

團隊首次提出了視覺-文字-語音三模態預訓練模型,實現了三模態間相互轉換和生成。其核心原理是視覺、文字、語音不同模態通過各自編碼器對映到統一語義空間,然後通過多頭自注意力機制(Multi-head Self-attention)學習模態之間的語義關聯以及特徵對齊,形成多模態統一知識表示,再利用編碼後的多模態特徵,然後通過多頭自注意力機制進行通過解碼器分別生成文字、影象和語音。這裡三模態互相轉化和相互生成示意如圖1所示:

圖1. 圖文音三模態相互轉換與生成

多層次多工自監督預訓練學習

此次提出的三模態預訓練模型由單模態編碼器、跨模態編碼器和跨模態解碼器構成。針對圖文音三模態資料,我們提出三級預訓練自監督學習方式:詞條級別 (Token-level,Modality-level),模態級(Modality-level masking)以及樣本級別(Sample-level masking) 。具體包括:

(1)詞條級別(Token-level)學習

文字掩碼建模(Masked Language Modeling):隨機掩蓋一些文字單詞,需要模型根據上下文預測被掩蓋的單詞是什麼;視覺掩碼建模(Masked Vision Modeling):隨機掩蓋一些影象區域,讓模型預測被掩蓋的區域;語音掩碼建模(Masked Audio Modeling):隨機掩蓋一些語音詞條(token),模型需要預測被掩蓋的詞條(token)是什麼。

(2)模態級別(Modality-level)學習

包括文字重構和影象重構兩個任務,分別學習重構輸入文字和影象。團隊引入模態級別掩碼(Modality-Level Masking)機制隨機地掩蓋一個模態資訊,使得模型需要根據其他模態資訊對當前模態進行重構,從而能夠進行下游的跨模態生成任務。這個機制也帶來另一個好處—它使我們的模型不僅能夠處理三模態輸入,也能處理兩模態輸入,從而適應下游的兩模態任務。

(3)樣本級別(Sample-level)學習

該預訓練任務是通過對每個樣本隨機地替換三種模態資訊中的一種或兩種,讓模型來預測替換哪些模態。

實驗結果

我們主要採用Open Images資料集作為預訓練資料,該資料包含影象、文字與音訊資料。此外我們也額外地使用兩模態資料,如Conceptual Caption圖文資料集,Visual Genome圖文資料集等。當加入額外的兩模態資料時,這些兩模態與三模態資料則被隨機混合進行訓練。

研究團隊主要進行了以下兩方面的實驗驗證:

(1)圖文音三模態關聯編碼與相互生成效能

分別在多模態融合的影象分類、任意兩模態的相互檢索以及語音識別任務中,與常規全監督方法進行了效能比較,均取得了效能上的顯著提升。其中在多模態融合的影象分類任務中,與常規全監督的Resnet101網路模型相比,效能提升5個百分點;加入語音模態資訊能夠明顯提升以文搜圖的效能,驗證了聯合建模視覺-文字-語音三模態資訊的必要性。

(2)多模態下游任務效能

分別在跨模態檢索、視覺問答與影象語義描述任務中,與當前最新的圖文兩模態預訓練模型進行了效能比較,在補充了圖文兩模態資料參與預訓練的模型上,取得了具有競爭力甚至更好的實驗效能。

總結

三模態預訓練模型的提出將改變當前單一模型對應單一任務的人工智研發正規化,三模態圖文音的統一語義表達將大幅提升文字、語音、影象和視訊等領域的基礎任務效能,並在多模態內容的理解、搜尋、推薦和問答,語音識別和合成,人機互動和無人駕駛等商業應用中具有潛力巨大的市場價值。

「大資料+大模型+多模態」多工統一學習將引領技術發展的潮流

相關文章

機器之心專欄作者:紫冬君中國科學院自動化研究所日前,中科院自動化所提出了全球首個圖文音(視覺-文字-語音)三模態預訓練模型(OPT-Omni-Perception pre-Trainer),同時具備跨模態理

2021-07-11 03:03:17

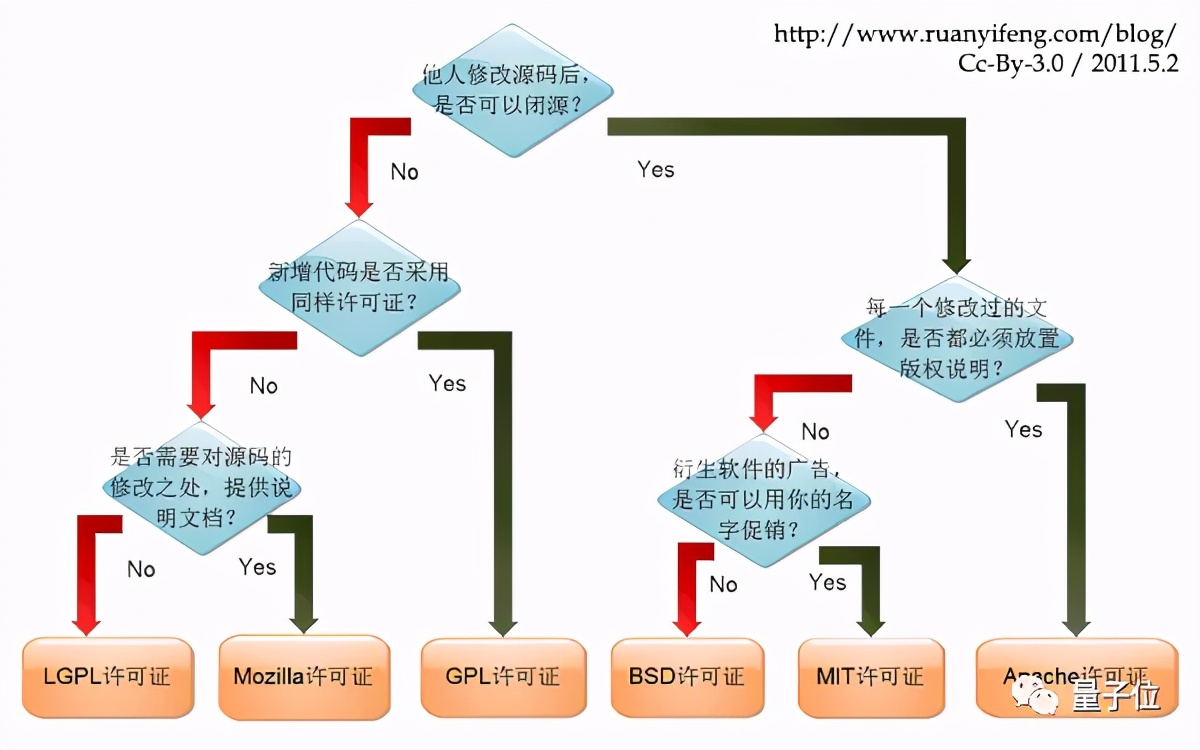

博雯 發自 凹非寺量子位 報道 | 公眾號 QbitAI「他們簡直是不知羞恥。」7月7日,一位網友在推特上公開炮轟GitHub:這位使用者貼出了一封GitHub的郵件回覆。郵件中,GitHub官方確

2021-07-11 03:03:07

Open Source,Open World。7 月 9 日,由開放原子開源基金會與 Linux 基金會聯合開源中國共同舉辦的【GOTC 全球開源技術峰會】在上海世博中心正式拉開帷幕。來自全球各個頂級開

2021-07-11 03:02:46

滴滴遭全面下架據前段時間滴滴出行客戶端遭全網下架之後,在昨日 7 月 9 日晚,網信辦釋出新訊息,宣佈繼續下架滴滴相關的 25 款應用。這些應用中包括滴滴最重要的 滴滴企業版,滴

2021-07-11 03:02:33

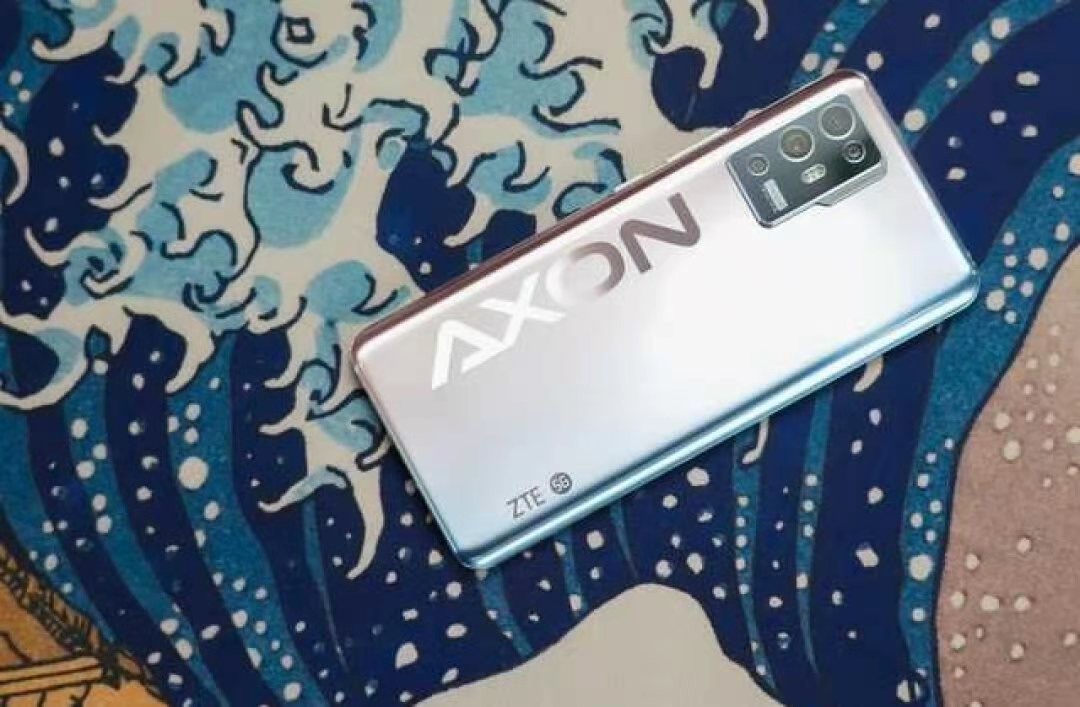

目前價格比較便宜的驍龍888手機,怎麼數也就是三款了,第一款是Redmi K40 Pro手機,目前8GB+128GB版售價是2999元;第二款是realme GT,目前8GB+128GB版的價格是2599元,價格比較便宜,不

2021-07-11 03:02:28

【7月10日訊】相信大家都知道,自從6月2日華為正式釋出了鴻蒙OS 2.0系統以後,華為方面就開始不斷地加速旗下舊機型適配升級鴻蒙OS系統的計劃流程,在短短不到一個禮拜時間內,鴻蒙O

2021-07-11 03:02:22