瑪格麗特·米切爾 (Margaret Mitchell) 於 4 月在華盛頓州西雅圖市攝影師:Chona Kasinger/彭博社雷鋒網8月25日訊息,谷歌Ethical AI人工智慧倫理研究小組前負責人瑪格麗特·米

2021-08-26 03:03:24

瑪格麗特·米切爾 (Margaret Mitchell) 於 4 月在華盛頓州西雅圖市

攝影師:Chona Kasinger/彭博社

雷鋒網8月25日訊息,谷歌Ethical AI人工智慧倫理研究小組前負責人瑪格麗特·米切爾(Margaret Mitchell)將加入人工智慧創業公司Hugging Face,幫助企業開發確保其演算法公平的工具。她因與他人合著的一篇重要論文引起爭議而在今年2月被谷歌解僱。

Hugging Face有何吸引力?

Hugging Face 是一家總部位於紐約的聊天機器人初創服務商,專注於NLP技術,擁有大型的開源社群。尤其是在github上開源的自然語言處理,預訓練模型庫 Transformers,已被下載超過一百萬次,github上超過24000個star。Transformers 提供了NLP領域大量state-of-art的預訓練語言模型結構的模型和呼叫框架。

Transformers最早的名字叫做pytorch-pretrained-bert,推出於google BERT之後。顧名思義,它是基於pytorch對BERT的一種實現。pytorch框架上手簡單,BERT模型效能卓越,集合了兩者優點的pytorch-pretrained-bert吸引了大批的追隨者和貢獻者。

其後,在社群的努力下,GPT、GPT-2、Transformer-XL、XLNET、XLM等一批模型也被相繼引入,整個家族愈發壯大,這個庫更名為pytorch-transformers。

2019年6月Tensorflow2的beta版釋出,Huggingface實現了TensorFlow 2.0和PyTorch模型之間的深層互操作性,可以在TF2.0/PyTorch框架之間隨意遷移模型。之後也釋出2.0版本,並更名為 transformers 。到目前為止,transformers 提供了超過100+種語言的,32種預訓練語言模型。

Hugging Face維護著一個儲存庫,人們可以在儲存庫中共享AI模型並進行合作。這是一個開放原始碼平臺,目前已經有5000多家機構使用,其中包括谷歌、Facebook、和微軟。米切爾計劃在10月份啟動,並將首先開發一套工具,以確保用於訓練人工智慧演算法的資料集不存在偏見。目前用於「教導」模型如何進行預測或確定的資料集,通常因為原始資料的不完整會導致AI軟體在女性、少數群體成員還有老年人中表現不佳。

米切爾和Hugging Face已經建立了關係,因為為了確保模型的公平性,Hugging Face建議工程師和科學家在釋出項目時使用米切爾在谷歌開發的名為「Model Cards」的工具來評估人工智慧系統,以揭示優缺點。Hugging Face執行長兼聯合創始人克萊門特·德蘭吉(Clement Delangue)表示,放在Hugging Face上的20000個項目中,約有四分之一使用了Model Cards工具。

Hugging Face 在其 50 人的員工中還有幾位人工智慧倫理專家,但 CEO 德蘭格(Delangue )計劃讓所有員工對這項工作負責並努力。

德蘭格表示:「我們不想建立一個輔助的人工智慧倫理團隊,而是真正讓它成為公司的核心,並確保它真正融入每個人的工作。米切爾不會建立一個由少數人組成,只是偶爾提供諮詢的團隊。」

米切爾在一次採訪中表示,在用軟體評估人工智慧系統方面,"要用非常嚴肅和積極的態度去工作。「這對我來說是一個非常好的機會,可以幫助模型構建者更好地理解他們正在構建的模型的危害和風險。」

米切爾在從谷歌離職後表示,她希望在一家規模較小的公司工作,這樣可以從一開始就將人工智慧倫理納入在考慮內。她說,在Hugging Face中,「已經有很多基本的道德價值觀」。「很明顯,我不必強行插手或改進倫理流程。」

米切爾究竟為何被解僱?

米切爾的解僱源於谷歌人工智慧倫理研究團隊的動盪。去年,谷歌公司就解僱了該團隊的另一位聯合負責人蒂姆尼特·格布魯(Timnit Gebru),原因是她拒絕撤回與米切爾等人共同撰寫的一篇論文,這篇文章涉及到對谷歌技術的批評。Gebru離職後,作為團隊剩餘負責人的米切爾公開強烈批評谷歌及其管理層,指責谷歌未能認真對待對其人工智慧產品的問題,以及解僱Gebru的做法,因為Gebru是人工智慧研究領域為數不多的傑出黑人女性之一。谷歌則表示, Gebru 已辭職,Mitchell 違反了谷歌的行為準則和安全政策。

谷歌的員工對其處理此事的方式表示憤慨,今年早些時候,對十多名現任和前任員工以及人工智慧學術研究人員的採訪表明,在兩年多的時間裡谷歌的人工智慧的工作,在處理騷擾、種族主義和性別歧視指控方式上一直陷於爭議之中。

提到這篇論文,大致集中攻擊了大規模語言模型(如BERT)的消極影響,而BERT模型是谷歌的王牌AI產品之一。

這篇論文名為《On the Dangers of Stochastic Parrots: Can Language Models Be Too Big?》。

據瞭解,這篇論文基於其他研究人員的工作,參考了128篇學術文獻,展示了自然語言處理的發展歷史與大型語言模型的四大危害,呼籲對語言模型進行更深入的研究。

這四大危害包括:

1、訓練大型AI模型會消耗大量能源;(訓練一個BERT模型大約會產生1,438磅二氧化碳,相當於在紐約與舊金山之間的一次往返航班所產生的碳排放量。)

2、大型語言模型是基於大量文字進行訓練,無法避免偏見的存在,包括那些涉及種族歧視的、具有性別歧視色彩的與其他虐待性的語言;

3、大型語言模型無法理解語言,但公司由於利益關係會加大這方面的投入,從而帶來機會成本;

4、由於大型語言模型非常擅長模模擬實的人類語言,所以很容易被用來欺騙人類。

谷歌在許多基礎研究上遙遙領先,這帶來了大型語言模型的最新爆炸式增長。如果真的如論文所說大規模語言模型「危害大於利益」,而谷歌解僱一系列人員,那對這件事的態度也就不言而喻了。或許從這個角度就能理解米切爾加入Hugging Face的原因了。

(公眾號:雷鋒網)雷鋒網

參考資料

https://www.bloomberg.com/news/articles/2021-08-24/fired-at-google-after-critical-work-ai-researcher-mitchell-to-join-hugging-face

相關文章

瑪格麗特·米切爾 (Margaret Mitchell) 於 4 月在華盛頓州西雅圖市攝影師:Chona Kasinger/彭博社雷鋒網8月25日訊息,谷歌Ethical AI人工智慧倫理研究小組前負責人瑪格麗特·米

2021-08-26 03:03:24

美圖影像實驗室(MT Lab)利用 StyleGAN 技術落地了多個頭發生成項目並在美圖秀秀及海外產品 AirBush 上線劉海生成、髮際線調整與稀疏區域補發等功能。媽媽再也不用擔心我脫髮

2021-08-26 03:03:10

博雯 發自 凹非寺量子位 報道 | 公眾號 QbitAI最近的Google Pay,正深陷於離職浪潮之中。今年4月底副總Caesar Sengupta的離職,就像是拉開了出走的序幕。△Sengupta在LinkedIn

2021-08-26 03:03:02

Win7系統中有許多自定義小功能,可根據您自己的偏好定製。特派團董事會顏色可以從傳統藍色變為其他各種顏色,但很多使用者不知道在哪裡設定它。讓我們帶給你詳細的教程。如果你

2021-08-26 03:02:52

出品|開源中國文|Travis知名開源項目 Grafana 的開發商 Grafana Labs 近日在 C 輪融資中獲得了 2.2 億美元,在獲取該筆投資後,Grafana Labs 的估值目前已達到 30 億美元,相比兩

2021-08-26 03:02:39

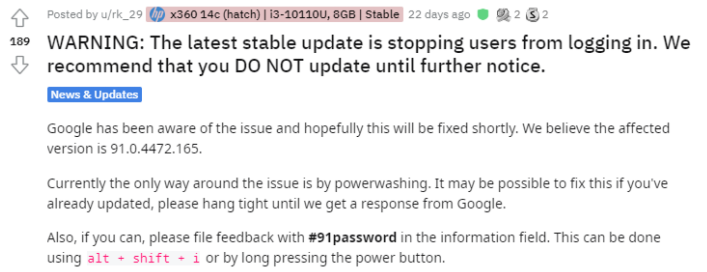

近期谷歌推送了新版本,但是沒想到這次更新就出現了重大Bug。 使用者反映安裝了新版本之後,自己的電腦陷入了無限重啟的狀態,最終恢復了出廠設定才好。我們都知道Chrome OS是一

2021-08-26 03:02:32