新一代人工智慧已經邁向「煉大模型」的時代。這一切源於GPT-3的橫空出世,這個具有1750億的參數的通用預訓練模型不僅帶來了超乎想象的生成能力,更讓人們看到了「超大模型」實

2021-06-09 14:45:48

新一代人工智慧已經邁向「煉大模型」的時代。這一切源於GPT-3的橫空出世,這個具有1750億的參數的通用預訓練模型不僅帶來了超乎想象的生成能力,更讓人們看到了「超大模型」實現通用人工智慧的潛力。

2021年1月,距離GPT-3問世不足一年,Google重磅推出Switch Transformer模型,將參數量提升到1.6萬億,成為人類歷史上首個萬億級語言模型。然而,人們對預訓練語言模型的想象遠不止如此,隨著算力的提升,大資料的湧現,越來越多學術機構和企業加入」煉大模型「的行列,在這場激烈的軍備賽中,誰將成為下一位贏家?

6月1日,2021北京智源大會在中關村國家自主創新示範區會議中心如期拉開大幕,開幕式上,清華大學教授,智源研究院學術副院長唐傑重磅釋出了超大規模智慧模型「悟道2.0」。

經過近三個月的技術迭代,悟道2.0參數量達到1.75萬億,創下全球最大預訓練語言模型記錄。

唐傑教授表示,「悟道」超大模型智慧模型旨在打造資料和知識雙輪驅動的認知智慧,讓機器能夠像人一樣思考,實現超越圖靈測試的機器認知能力。

「悟道」由智源研究院學術副院長、清華大學唐傑教授領銜,帶領來自北大、清華、人大、中科院等高校院所,以及阿里等諸多企業的100餘位AI專家共同研發,是國內首個超大預訓練語言模型系統。

本次釋出的「悟道2.0」實現了「大而聰明」,具備大規模、高精度、高效率的特點。

與悟道1.0相比,「悟道2.0」不僅在模型規模上實現了萬億級參數的跨越,還在世界公認的9項 Benchmark 上達到了世界第一,在多項基準測試中超越OpenAI GPT-3、DALL·E以及Google ALIGN等先進模型。

另外,悟道2.0完全基於國產神威超算實現萬億級規模訓練,並且打破了原來只能用GPU訓練的侷限。

我們注意到,GPT-3、Turing-NLG等主流的超大預訓練模型均出自科技企業,國內最大的預訓練語言模型也為阿里研發的PLUG(270億參數),悟道2.0的釋出意味著,智源研究院成為了「大煉模型」的首家科研機構,並且在國內接棒企業成為了「煉大模型」的主力。

在本屆峰會上,基於中文、多模態、認知三個方面,悟道2.0帶來了哪些底層技術創新,為何悟道2.0參數能夠在短時間內實現爆發式增長?大會還有哪些全新升級,接下來3點陣圖靈獎得主,200位頂級專家就前沿科技將分享哪些真知灼見?下面我們來一一來揭曉答案。

悟道2.0成功實現萬億級突破,得益於FastMoE演算法。

FastMoE的研發靈感來源於MoE(Mixture of Experts)。MoE一項在神經網路中引入若干專家網路(Expert Network)的技術,也是Google釋出的1.5萬億參數預訓練模型Switch Transformer的核心技術。

FastMoE在提升預訓練模型參數量方面有著巨大的潛力。

如對於每個輸入,MoE動態地由門網路選擇k個專家網路進行啟用,一般情況下,每個輸入x啟用的專家網路數量都很少,如512個專家網路可能只挑選兩個。在運算量(FLOPs)不變的情況下,這有利於增加模型參數量。

在一項實驗中,Google將MoE應用到基於Transformer的神經機器翻譯的任務上,使用2048個TPU v3 cores花4天時間訓練了一個6千億參數的模型。

不過,MoE對Google分散式訓練框架mesh-tensorflow和定製硬體TPU有較強的依賴性,這給其他人開源社群的使用和研究帶來了不便。

智源研究院為此以MoE為原型研發了一種易用性強、靈活性好、訓練速度快的FastMoE系統,它可以在不同規模的計算機或叢集上支援不同的MoE模型。而且,相比MoE,有如下技術優勢:

既可以作為PyTorch模組使用,也可以引入Gate變為MoE層。

支援將任意神經網路模組作為專家網路使用,僅需要修改MoE層的一個參數。

相比直接使用PyTorch實現的版本,提速47倍。

支援大規模並行訓練

為了支撐這個萬億級模型,悟道2.0配備了國產超算GPU打造的高效能算力平臺。唐傑教授表示,隨著算力的不斷提升,模型或許有一天能夠達到與人腦突觸量級相當的 100 萬億參數規模。當然模型越大,意味著更高的訓練成本,GPT-3一次訓練費用可達到了數千萬美元。

在資料方面,智源研究院創建了全球最大中文語料資料庫WuDaoCorpora,規模達3TB,超出之前最大的中文語料庫CLUECorpus2020十倍以上。在悟道2.0中,WuDaoCorpora擴展了多模態資料集(90TB)和中文對話資料集,其資料規模達(181GB)。

參數量越大不代表模型效能一定越好。在悟道2.0中,40億參數的多模態預訓練模型CogView,在MS COCO資料集上比擁有130億參數的DALL·E表現更好。因此,在大資料和算力的支援下,演算法的效能更為重要。谷歌釋出的Switch Transformer,雖然達到了萬億級規模,但其下游任務的精度並沒有大幅度提升。

為了提高超大規模預訓練模型的精度和效率,悟道2.0從模型、訓練、微調、推理等環節對演算法進行了全鏈路升級:

高效模型:首創純非歐空間模型,50%參數量即可達到近似歐式模型的效果。

高效訓練:首創預訓練語言模型融合框架「知識繼承」,可使訓練時間縮短 27.3%,速度提升37.5%。它的核心思想是提取已有的小預訓練語言模型模型蘊藏的「隱式」知識,並將其注入超大規模模型當中。

高效微調:首創基於檢索的半監督少樣本的微調演算法Prompt,只要需訓練0.2%資料即可達到完整資料訓練90%的效果。

高效推理:首創低資源大模型推理系統,單機單卡GPU即可以進行千億參數規模的模型推理。

如何將中文融入預訓練模型,推動中文應用背景下的人工智慧發展?如何實現圖、文和視訊等多模態資訊之間理解與建模的統一?如何提升大規模預訓練模型的語言理解能力?如何進一步實現對超長/複雜蛋白質序列的建模和預測?

圍繞這些問題,悟道2.0創建文源、文瀾、文匯、文朔四大預訓練模型,經過一系列底層演算法升級,在世界公認的9項 Benchmark 上達到了世界第一!

GLM+CogView+Inverse Prompting—文匯

在悟道2.0中,參數量達1.75萬億的超大規模預訓練語言模型便是悟道·文匯,基於GLM+P-tuning+Inverse Prompting+CogView多項創新演算法,文匯能夠學習不同模態(文字和視覺領域為主)之間的概念,實現文生文、圖生文以及圖文生文等多項任務。

文匯是面向認知的萬億級多模態模型,旨在解決大規模自監督預訓練模型不具有認知能力的問題。目前,1.75萬億級規模的文匯已經具備初級認知能力,並且在開放對話、知識問答、可控文字生成等認知推理任務上均有不錯的表現。而這得益於四項演算法創新:

文匯是面向認知的萬億級多模態模型,旨在解決大規模自監督預訓練模型不具有認知能力的問題。目前,1.75萬億級規模的文匯已經具備初級認知能力,並且在開放對話、知識問答、可控文字生成等認知推理任務上均有不錯的表現。而這得益於四項演算法創新:

首先是通用預訓練框架GLM。GLM能夠同時在分類、無條件生成和有條件生成三類NLP任務取得最優結果;在訓練資料相同的前提下,其在SuperGLUE自然語言理解基準上的效能表現遠超BERT;並且更擅長填空問題以及內容生成。

其次是P-tuning,一種用連續的向量來表示Prompt的方法,它解決了Prompt在少樣本學習場景下容易過擬合的問題,即「通過連續向量輸入,直接在連續空間裡尋找Prompt的最優解。」

在知識探測任務(LAMA)上,不需要任何額外文字,P-tuning提取的知識可以達到超過60%的準確率,超越之前最好結果20個百分點。此外,P-tuning在少樣本學習中優於包括PET和GPT-3在內的所有few-shot learning的SOTA方法。

第三是Inverse Prompting,它解決了預訓練模型「答非所問」的難題,其核心思路是用生成的內容反過來以同樣的模型預測原來的Prompt,從而保證問題與答案之間較強的關聯性。

最後是CogView,通過40億參數的Transformer模型和VQ-VAE影象分詞器解決了跨模態理解的問題。類似於OpenAI 釋出的DALL·E,CogView可以根據文字提示生成對應影象,不過其效能表現在MS COCO資料集上要優於DALL·E以及基於GAN的模型。

以上演算法創新只是第一步,文匯的長期目標是從預測去構造決策,包括完全解決少樣本問題,並通過對預訓練和微調模式的創新,進一步接近認知目標。

雙塔預訓練結構-文瀾

「悟道·文瀾是多模態多語言預訓練模型。文瀾2.0首次實現了7種不同的語言的生成和理解,包括中、英、法、德、捷克、日、韓。在中文公開多模態測試集AIC-ICC影象生成描述任務中,得分比冠軍隊高出5%;在圖文互檢任務中,比目前最流行的UNITER模型高出20%。另外,在圖文檢索和影象問答任務上均超過現有多模態多語言預訓練模型。

不同於大多預訓練模型,文瀾模型獨創性地採用了一種基於多模態對比學習的雙塔結構(Bridging Vision and Language,BriVL),與常見的單塔架構相比,BriVL在影象和文字之間建立了「弱相關」假設,在圖文互檢任務中能夠表現更好的效能。

重要的是,這種基於視覺-語言的弱相關假設也在一定程度上解決了大資料標註難題,如唐傑教授所說,「標註資料很稀缺,如今我們對資料規模的需求越來越大,對億級資料進行標註幾乎不可能實現。所以未來,弱相關的多模態訓練是一個大趨勢。」

為了彌補神經網路在表達上的損失,BriVL結構中引入了監督學習和對比學習。BriVL首先使用獨立的語言和視覺編碼器提取語言和視覺資訊的特徵向量,然後將這些向量傳入到對比學習模組中進行訓練。

採用這樣的雙塔結構,可以很方便地把編碼器模組替換為最新的單模態預訓練模型,從而可以持續增強模型表達能力。

此外,文瀾還提出了基於 DeepSpeed 的多模態預訓練演算法,能夠最大化的用 GPU 和 CPU,並最優地支援跨模態對比學習。

首創高效混合編碼機制-文源

悟道·文源是以中文為核心的大規模預訓練模型,具有識記、理解、檢索、數值計算、多語言等多種能力。在開放域回答、語法改錯、情感分析等20種主流中文自然語言處理任務中均優於同等參數量模型。

區別於其他模型,文源最大的創新之處在於採用了獨特的資訊編碼方式。作為最複雜的語言體系之一,中文語料庫中的生僻字、形近字、音近字為模型訓練帶來了諸多挑戰。

智源研究院為此首創了一種基於字音和字形的混合高效編碼機制,它與目前普遍使用的基於中文單字的編碼方式相比具有更好穩定性。基於新型編碼機制訓練後得到的兩大模型「說文」和「解字」,在文字分類,句對分類,閱讀理解任務中的得分平均高於後者0.6個點。

另外,這種編碼方式對於形近字和同音字等常見錯別字場景也具有一定優勢。比如,對於中文簡體字的繁體字、異體字變種,基於字形的編碼方式可以將複雜漢字拆解成更為常見的部首組合,幫助模型更好地理解複雜的異體字、罕見字。有實驗資料顯示,在資料集存在異體字噪聲場景下,該模型優於中文單字編碼機制最高18.8個點。

不僅僅侷限於中文,文源也有向英文擴展的能力,並在一系列偏向實際應用層面的英文任務上超越了GPT-3。文源下一階段的目標是嘗試用跨語言模型將不同語言的專家模型連線到一起,實現模型的多語言擴展。

「悟道」的定位從一開始就很明確:從更加本質的角度進一步探索通用人工智慧。

去年10月,智源研究院啟動新型超大規模預訓練模型研發項目正式啟動,智源研究院院長黃鐵軍在會上表示,近年來人工智慧的發展,已經從「大煉模型」逐步邁向了「煉大模型」的階段,通過設計先進的演算法,整合儘可能多的資料,匯聚大量算力,集約化地訓練大模型,供大量企業使用,這是必然趨勢。

目前,GPT-3等預訓練語言模型提供了一條探索通用人工智慧的可能路徑,OpenAI、谷歌、Facebook等國際IT企業都在此持續加碼,然而,隨著Turing NLG、BERT、GPT-3、Switch Transformer等重磅成果不斷被髮布,以中文為核心的預訓練模型仍寥寥無幾,在此發展態勢下,研發我國自主的大規模預訓練模型勢在必行。

與此同時,悟道啟動以中文為核心的文源、基於多模態的文瀾、面向認知的文匯、以及用於蛋白質預測的文溯四大預訓練模型,其目標在於解決目前國際主流模型存在的前沿問題。

我們知道,雖然GPT-3在多項任務中表現出色,寫小說、做圖表、寫程式碼統統不在話下,但它並沒有通過圖靈測試。它最大的問題是沒有常識,不具備認知能力。 此外,它在處理開放對話、基於知識的問答、可控文字生成等複雜的認知推理任務上,也與人類智慧有較大差距。

基於此,悟道·文匯希望從更本質的認知層面去探索通用人工智慧的潛力。

悟道·文瀾嘗試通過多模態解決現實場景的需求。隨著自然語言處理、計算機視覺以及語音識別等人工智慧技術日益成熟,如何實現大規模落地成為人們必須思考的問題。而面對複雜多變的現實場景,「多模態」成為了前沿技術走向產業應用的下一個突破口。

今年OpenAI打破語言與視覺的界限,推出文字生成影象模型DALL·E 和 CLIP達到SOTA效能;谷歌推出多語言多模態模型MUM,顯著提高了搜尋效率。

然而以上成果只是一個開端,人工智慧模型在文字、影象、音訊、視訊等不同資料類型之間的跨模態理解上仍面臨不小的挑戰。

悟道·文溯則旨在通過前沿技術加速推動電子資訊、生物醫藥等基礎科學科的科學研究程序。人工智慧技術在解決重大科學問題上表現出了巨大的潛力,尤其是蛋白質預測領域,去年DeepMind公司研究人員研發的AlphaFold,將蛋白質結構預測的準確度提高到了原子水平,解決了困擾科學界近50年的重大難題。

在此背景下,悟道嘗試以基因領域認知圖譜為指導,通過超大規模預訓練模型解決超長/複雜蛋白質序列的建模和預測問題。

在悟道2.0中,文源、文瀾、文匯、文溯均在標準測試中達到了世界領先水平。悟道在研發的同時,智源研究院也在同步探索其生態建設模式。隨著悟道2.0的釋出,其產業應用程序也進一步加快。

在開幕式上,智源研究院學術副院長唐傑教授現場與21家企業舉辦了合作簽約儀式,圍繞悟道2.0的產業應用,與美團、小米、快手、搜狗、360、寒武紀、好未來、新華社等21家企業達成了戰略合作。悟道2.0將以開放API(應用程式介面)的形式為這些企業提供服務。

此外,智源研究院還與新華社合作將悟道模型應用於新聞智慧化轉型,這是新聞領域0到1 的突破。在新聞領域,悟道模型能夠處理新聞下游任務, 包括新聞內容處理、圖文生成、傳播優化等,還具備接近人類的圖文創意能力,可以作詩、 問答、創意寫作等。

智源研究院副院長唐傑教授在會上表示,悟道2.0後續將支援智源研究院牽頭成立獨立的模型商業化運營公司, 並將面向個人開發者、中小創新企業、行業應用企業、IT領軍企業等不同主體,分別提供模型開源、API(應用程式程式設計介面)呼叫、「專業版」大模型開發、大模型開發許可授權等多種形態的模型能力服務,賦能AI技術研發。

可以預見,以智源2.0為代表的大模型將成為一個AI未來平臺的起點,成為類似「電」的基礎建設,為社會源源不斷供應智源。

悟道2.0的研發集結了中國人工智慧產業界和學術界的各方力量。

黃鐵軍表示,「我認為,未來真正賦值各行各業的大模型,在全世界範圍能都是屈指可數的,應該儘快把資源收斂到少數超大規模智慧模型上來。」

正是因為認識到這一點,智源研究院聯合了北京大學、清華大學、人民大學、中國科學院等單位的100餘位AI科學家聯合攻關悟道超大預訓練模型。

唐傑教授在會上表示,「我們的WuDaoCorpora是全球最大資料集的3倍,希望每一位都加入其中,我們做更大的資料,只有更大的資料、更大的算力,才能做出更優美的模型。」

為此,智源研究院在會上正式啟動了「智源學者計劃」,目標是遴選最優秀的科學家,共同探索人工智慧科技前沿「無人區」,挑戰最基礎的問題和最關鍵的難題。

截至目前,智源研究院已在人工智慧的數理基礎、人工智慧的認知神經基礎、機器學習、自然語言處理、智慧資訊檢索與挖掘、智慧系統架構與晶片等六大研究方向,遴選智源學者94人,分別來自北大、清華、中科院等高校院所與曠視、京東等優勢企業。值得關注的是,面向青年科研人員,智源研究院今年還成立了AI青年科學家學術組織「青源會」,為海內外的AI青年科學家和技術人員建立的寬鬆、活躍的學術交流平臺。

智源大會也是智源研究院為學者提供學術交流與思想碰撞的平臺,目前已經成功舉辦兩年。是國內人工智慧領域最具影響力的年度盛會。

由於採取極為嚴格的內行榮譽邀請制,智源大會的參會嘉賓均為人工智慧領域的頂級專家和學者,因而也被稱為真正的AI內行人盛會。

本屆大會邀請到了包括圖靈獎得主Yoshua Bengio、David Patterson在內的200多位頂級人工智慧專家。

包括加州大學伯克利分校教授Stuart Russell,宋曉冬(Dawn Song),澳大利亞科學院院士、ACM Fellow、AAAI Fellow Toby Walsh,康奈爾大學教授Carla Gomes,AAAI候任主席、康奈爾大學教授Bart Selman,Numenta聯合創始人、美國工程院院士Jeff Hawkins,北京大學、中國科學院院士鄂維南,清華大學國家金融研究院院長朱民,蒂賓根大學教授李兆平等。

此外,大會圍繞當前人工智慧領域的前沿熱門學研主題和產業落地主題設定了30多個專題論壇:

6月1日:開幕式和全體大會,預訓練論壇,人工智慧的數理基礎論壇,智慧體系架構與晶片論壇,AI科技女性論壇,AI人才培養論壇。

6月2日:青源學術年會,人工智慧倫理、治理與可持續發展論壇,全體大會,機器學習論壇,智慧資訊檢索與挖掘論壇,科學智慧論壇,產業畫像和精準治理中的AI創新應用論壇,決策智慧科學場景暨滴滴決策智慧模擬開放平臺釋出會,人工智慧的認知神經基礎論壇,精準智慧論壇,認知智慧論壇,晚間全體大會;

6月3日:AI創業論壇,AI交通論壇,自然語言處理論壇,國際AI研究機構論壇,強化學習與決策智慧論壇,人工智慧與社會經濟論壇,AI賦能生命健康與生物醫藥論壇,工業智慧論壇,視覺大模型論壇,AI製藥論壇,AI系統論壇,AI開放與共享論壇,AI安全與產業治理論壇,全體大會及閉幕式;

1、機器學習論壇(6月1日)

論壇主席:朱軍 清華大學教授,智源機器學習方向首席科學家

Opening the Black Box of Deep Learning: Some Lessons and Take-aways | Sanjeev Arora 普林斯頓大學電腦科學Charles C. Fitzmorris教授

Deep (Convolution) Networks from First Principles | 馬毅 加州大學伯克利分校教授

開放環境機器學習 | 周志華南京大學教授

可解釋性定義與可解釋模型的學習 | 張長水清華大學教授,智源研究員

2、認知神經基礎論壇(6月2日)

論壇主席: 劉嘉 - 清華大學教授,智源首席科學家

History and recent advances of deep learning theories | 甘利俊 帝京大學綜合科學研究機構特任教授、理化學研究所榮譽研究員

Data-driven Simulations of Basal Ganglia Microcircuits | Jeanette Hellgren Kotaleski 英國皇家理工學院教授,卡洛琳斯卡學院教授

Human brain works differently from Deep Learning technology | Danko NikolicEvocenta 人工智慧和資料科學主管

Challenging Artificial Intelligence Vision Algorithms to achieve human level performance | Alan Yuille Bloomberg 特聘教授

高精度模擬-生物智慧湧現之基石

3、視覺大模型(6月3日)

主席和主持人: 山世光 - 中科院計算所研究員

預訓練大模型的探索和實踐 | 田奇 華為雲人工智慧領域首席科學家

大規模視覺表徵學習 | 翟曉華谷歌大腦 研究員

我們賴以生存的意義和超大規模多模態預訓練 | 宋睿華中國人民大學高瓴人工智慧學院長聘副教授

當下AI領域最核心的學術及應用問題將在專題論壇中得到解答:

人工智慧的大統一理論(人工智慧的數理基礎論壇)

4、GPT-n需要什麼樣的智慧計算系統?(智慧體系架構與晶片論壇)

智慧製造的未來方向與技術壁壘(工業智慧)

AI系統的發展趨勢與挑戰(AI系統)

AI賦能生命健康與生物醫藥

5、需要特別強調幾個別樣的論壇:

預訓練論壇(6月1日下午):由智源研究院副院長唐傑教授帶領,將詳細解讀「悟道2.0」的技術細節。

青源學術年會(6月2日全天):不僅有自監督學習、圖神經網路前沿專題研討,還有一個屬於青年科研人員自己的組織在論壇釋出。

AI創業論壇(6月3日上午):智源研究院董事長張宏江博士將重磅釋出智源研究院對AI創業者的支援項目。

相關文章

新一代人工智慧已經邁向「煉大模型」的時代。這一切源於GPT-3的橫空出世,這個具有1750億的參數的通用預訓練模型不僅帶來了超乎想象的生成能力,更讓人們看到了「超大模型」實

2021-06-09 14:45:48

來源:Python爬蟲與資料探勘作者:崔豔飛一、前言大家好,我是崔豔飛。工作中經常會遇到,需要把兩張Excel或Csv資料表通過關鍵欄位進行關聯,匹配對應資料的情況,Excel雖有Vlookup函數

2021-06-09 14:45:32

小米子品牌紅米現在風生水起了,自從林斌將紅米交給盧偉冰後,盧偉冰進行了很大的整改,這讓雷軍非常滿意,盧偉冰也因此很快晉升小米合夥人,成為最快升職的職場達人。盧偉冰親手操辦

2021-06-09 14:45:08

Adobe Acrobat和Reader是美國Adobe公司PDF文件軟體,Adobe Reader免費使用,可查閱PDF文件,無法進行修改加水印等編輯操作,而Adobe Acrobat則是收費的,除了基本查閱PDF外,可進行高階

2021-06-09 14:44:56

IT之家 6 月 9 日訊息 AMD 今日正式釋出了 Radeon PRO W6000 系列工作站顯示卡,採用 RDNA 2 架構,為專業使用者提供卓越效能、穩定性以及可靠性。全新 AMD Radeon W6000 系列

2021-06-09 14:44:20

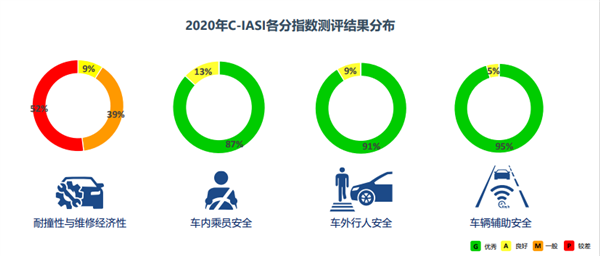

6月9日訊息,中保研在在北京召開中國保險汽車安全指數媒體釋出會,釋出了C-IASI 2020年測評結果研究報告。在2020年的測試評價工作中,C-IASI共完成23款車型的測試、釋出,其中SUV 1

2021-06-09 14:44:07