選自arXiv作者:Ashish Vaswani等機器之心編譯編輯:小舟來自谷歌研究院和 UC 伯克利的研究者開發了一種新的自注意力模型,該模型可以超越標準的基線模型,甚至是高效能的卷積模型

2021-06-10 14:23:40

選自arXiv

作者:Ashish Vaswani等

機器之心編譯

編輯:小舟

來自谷歌研究院和 UC 伯克利的研究者開發了一種新的自注意力模型,該模型可以超越標準的基線模型,甚至是高效能的卷積模型。

與卷積的參數依賴(parameter-dependent)縮放和內容無關(content-independent)互動相比,注意力場具有與參數無關的縮放和與內容有關的互動,因此自注意力機制有望改善計算機視覺系統。

近來的研究表明,與 ResNet-50 等基線卷積模型相比,自注意力模型在準確性 - 參數權衡方面有重要改進。

在一篇 CVPR 2021 Oral 論文中,來自谷歌研究院和 UC 伯克利的研究者開發了一種新的自注意力模型,該模型不僅可以超越標準的基線模型,而且可以超越高效能的卷積模型。

論文地址:https://arxiv.org/abs/2103.12731

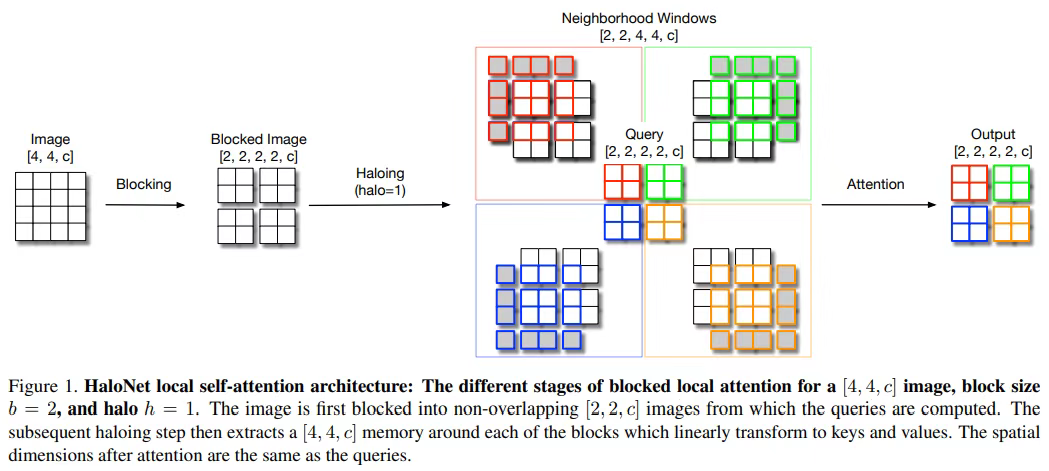

具體而言,該研究提出了自注意力的兩個擴展,並與自注意力的更高效實現相結合,提高了這些模型的運行速度、記憶體使用率和準確率。研究者利用這些改進開發了一種新的自注意力模型——HaloNet,並且在 ImageNet 分類基準的有限參數設定上準確率實現了新 SOTA。HaloNet 局部自注意架構如下圖 1 所示:

在遷移學習實驗中,該研究發現 HaloNet 模型的效能優於更大的模型,並且具有更好的推理效能。在目標檢測和例項分割等較難的任務上,該研究簡單的局部自注意力和卷積混合演算法在非常強大的基線上顯示出效能提升。

這些實驗結果標誌著在卷積模型主導的傳統環境下,自注意力模型又邁出了新的一步。

方法概述

儘管該研究的模型使用自注意力代替卷積來捕獲畫素之間的空間互動,但它們採用了現代卷積神經網路(CNN)的一些重要架構特徵。並且,和卷積神經網路一樣,該研究計算多尺度特徵層次結構,這些層次結構可以在局部化和例項分割等任務上以多種尺寸進行目標檢測。

因此,該研究開發了一個 strided 自注意力層,它是 strided 卷積的自然擴展。為了在無法引起全局注意力的較大解析度下處理計算成本,研究者遵循局部處理(也是卷積和自然感知系統的核心)的通用原則,並使用自注意力的空間受限形式。下圖 2 為注意力下采樣層的工作流程:

該方法沒有使用平移等價性(translational equivariance)來代替更好的硬體利用率,從而改善了速度和準確率之間的權衡。儘管使用的是局部注意力,但每個畫素的感受野卻非常大(達到了 18×18),並且更大的感受野有助於處理更大的影象。

此外,研究者還介紹了用於視覺任務的自注意力,並描述瞭如何放鬆平移等價性,以有效地將局部自注意力對映到硬體。

實驗結果

每個 HaloNet 模型(H0–H7)都是通過連續提升表 2 中定義的超參數的值來設計的。研究者後續還會進行比肩 EfficientNet 的更大 HaloNet 模型的訓練和評估工作。

可與 SOTA 卷積模型媲美

該研究在 ImageNet 基準上訓練了 HaloNet 模型,批大小是 4096,學習率是 1.6,線性預熱了 10 個 epoch,然後進行了餘弦衰減。模型用 Nesterov 的加速梯度(Accelerated Gradient)訓練 350 個 epoch,並使用 dropout、權重衰減、RandAugment 和隨機深度進行了正則化。

研究者驗證了自注意力與視覺卷積各自的優勢,並進一步理解了自注意力視覺架構的最佳設計方式。

實驗結果如上表所示,帶有正則化的 HaloNet 比 ResNet 的效能增益更多,但是對 ResNet 中重要的架構化模組卻沒有顯著改進。

HaloNet 架構

研究者探究了放鬆平移等價性的影響以及鄰域視窗與光暈大小的關係。

如下圖 5 所示,放鬆平移等價效能夠提升準確率。

從下圖 6 可以發現隨著視窗大小的增加,準確率會不斷提高。特別是,將視窗大小從 6×6 增大到 12×12,準確率會提升 1.3%。這些結果表明,增加視窗大小可以用於擴展模型,而無需增加參數數量,這可能對生產環境有利。

卷積 - 注意力混合改善了速度 - 準確率權衡

在一組控制變數實驗中,該研究用卷積替代了自注意力,以瞭解當前注意力層最有利的地方。

在效能最優的模型(HaloNet H7)的每個階段中,表 4 展示了藉助 SE 模組用卷積替代注意力層的結果。除最後一個階段外,其他所有階段都進行卷積會產生最快的模型,儘管 top-1 準確率會顯著降低(1%)。在卷積和注意力上分別進行分配可最小程度地降低預測準確率,同時顯著改善訓練和推斷過程。未來研究者還將對改進的混合模型進行進一步的研究。

感興趣的讀者可以閱讀論文原文,瞭解更多研究細節。

相關文章

選自arXiv作者:Ashish Vaswani等機器之心編譯編輯:小舟來自谷歌研究院和 UC 伯克利的研究者開發了一種新的自注意力模型,該模型可以超越標準的基線模型,甚至是高效能的卷積模型

2021-06-10 14:23:40

明敏 發自 凹非寺量子位 報道 | 公眾號 QbitAI沒想到一家無名小公司宕機,竟讓全球大半網路癱瘓了一個來小時。這週二,當許多人像往常一樣重新整理網站時,突然發現頁面打不開了,

2021-06-10 14:23:33

黃仁勳,你是怎麼想的?不知道大家是否還記得前段時間網上有個熱門事件:一戶主關閉了自家的無線網路,結果被鄰居敲門,並且很氣憤、很生氣、很理所應當的表示,你為啥關閉自家無限網路

2021-06-10 14:22:31

今日,本田正式釋出了全新思域HATCHBACK版的預告圖,據悉將於6月24日在北京亮相,未來有望進入國內銷售。HATCHBACK版整體外觀會和三廂版幾乎保持一致,唯一的區別在於後備廂線條和

2021-06-10 14:22:04

618市場上降價的不僅有手機,筆記本,相機,其實白電降價也不少。最近評價君就發現小,一款2匹立式空調直降1200元,從4299元降至了3099元,價格十分犀利。這款空調是華凌的KFR-51LW/N8H

2021-06-10 13:40:50

今日,諾基亞手機官微再度釋出預熱海報,持續揭祕新品資訊。迄今為止,旗下 Nokia C20 Plus 及兩款新品配件均已開啟預熱,核心功能及主要賣點陸續釋放,並將於 6月 11 日上午10點正式

2021-06-10 13:39:13