機器之心釋出機器之心編輯部MAI(Mobile AI Workshop)是由 CVPR 主辦的 Workshop 競賽。近期,來自位元組跳動智慧創作團隊的 ByteScene 團隊在 MAI 2021 實時移動端場景檢測項目

2021-06-11 15:30:09

機器之心釋出

機器之心編輯部

MAI(Mobile AI Workshop)是由 CVPR 主辦的 Workshop 競賽。近期,來自位元組跳動智慧創作團隊的 ByteScene 團隊在 MAI 2021 實時移動端場景檢測項目上,以 163.08 分的絕對優勢奪得冠軍。

競賽結果及相關報告見:https://arxiv.org/pdf/2105.08819.pdf

競賽項目介紹

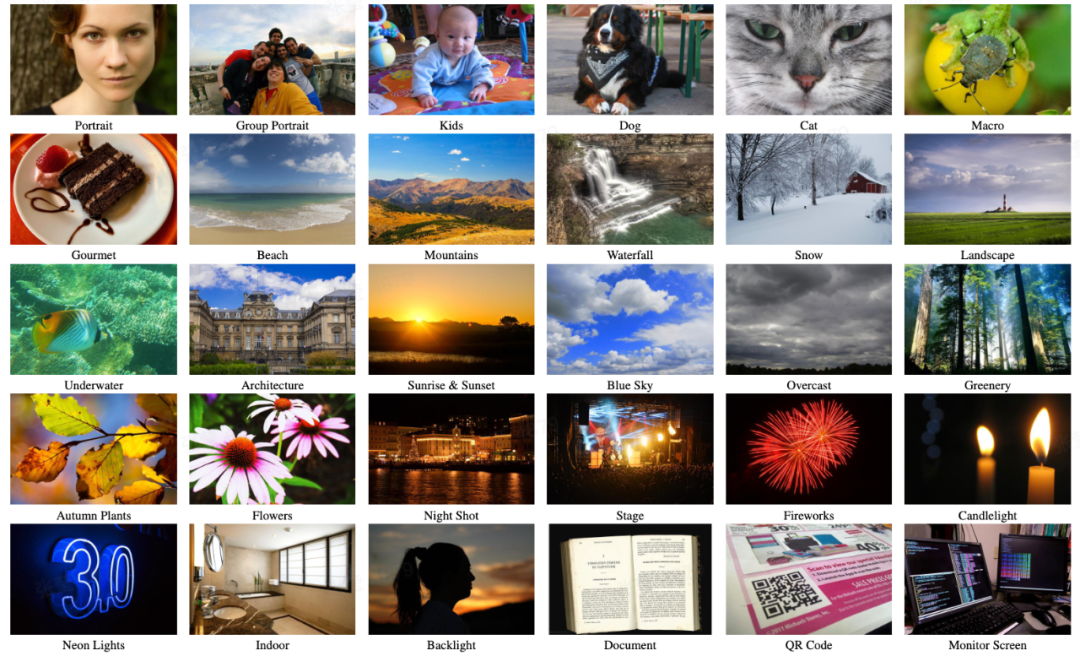

MAI 2021 實時移動端場景檢測競賽:基於 RGB 影象的實時高效能移動端場景類別預測,任務要求在移動端硬體上對攝像頭輸入的影象實時預測出其場景類別,總共有 30 個場景類別。

資料集:CamSDD (Camera Scene Detection Dataset) 資料集有超過 1.1 萬張攝像頭場景影象,每張影象都是解析度為 576x384 的 RGB 影象,且屬於 30 個場景類別中的某一個類別;其中 9897 張是有標註的訓練集影象,600 張是無標註的驗證集影象,還有 600 張是舉辦方保留的測試集影象,參賽者不會拿到測試集影象。

評測方法:參賽者需要將訓練好的影象場景類別預測模型轉換為 8 位量化的 TFLite 模型,並將 TFLite 模型上傳到舉辦方的伺服器。在舉辦方的伺服器上,TFLite 模型會被髮送到 Apple Bionic A11 SoC 移動端裝置上測試模型運行耗時,並在舉辦方保留的測試集上測試 Top-1 和 Top-3 識別準確率。

評價指標:

識別場景類別的 Top-1 準確率;識別場景類別的 Top-3 準確率;在 Apple Bionic A11 目標平臺上的運行耗時;

最終評分是依據公式(C 是一個常數的標準化係數)

團隊成績:來自位元組跳動智慧創作團隊的 ByteScene 團隊以 163.08 分的絕對優勢奪得冠軍。

競賽難點:

本次場景檢測演算法比賽要求兼顧在移動端上的速度和識別準確率,需要優化足夠輕量級的高精度小模型;訓練集資料量有限,存在較大的過擬合(Overfit )風險;

演算法背景介紹

自動預測攝像頭影象的場景類別是智慧手機上的一項基礎演算法能力,手機相機可以根據當前的攝像頭影象場景類別對成像參數進行自動調節,以拍出最佳效果的圖片和視訊。為了能達到實時自動調節手機相機的能力,需要場景類別預測演算法能在手機上實時運行,同時保證識別準確率。這對演算法設計者來說,是一項很大的挑戰。

位元組跳動的 ByteScene 團隊使用遷移學習的方法訓練大模型和移動端小模型,並使用遷移後的大模型對過濾後的額外資料打上偽標籤,利用這些額外資料和原有訓練集訓練出了移動端高效且高準確率的場景檢測演算法。

演算法技術方案

ByteScene 團隊使用了一種受 Google 的 Big transfer 工作啟發的遷移學習方法來訓練大模型和移動端小模型(如圖 3)。移動端小模型是使用如表 3 所示的 MobileNetV3-Like 架構,該架構在 ImageNet 2012 驗證集上獲得了 67.82% 的 Top-1 準確率,它是使用位元組跳動智慧創作團隊自研的 NAS 演算法搜尋出來的,該模型只有 86M FLOPs 的計算量。ByteScene 通過將輸入影象的解析度從 576×384px 縮小為 128×128px,大大減少了計算量。

圖 3.ByteScene 團隊使用的演算法模型訓練方案

大模型的訓練

ByteScene 團隊基於 ResNet101x3 主幹網路建立了分類大模型,首先保留 1003 張有標籤影象作為自用驗證集,在 CamSDD 訓練集上對帶有預訓練的大模型進行了微調。在微調過程中,它的主幹被固定住,並且使用 AdamW 優化了 10 個 epoch。然後,ByteScene 利用訓練好的第一版大模型對官方的驗證集打上偽標籤,得到新的驗證集後,利用所有可用的訓練影象對大模型進行再次訓練。最終訓練得到的大模型在官方驗證集上達到了 97.83% 的 Top-1 準確率。

移動端模型訓練

ByteScene 利用訓練好的大模型過濾出了 2577 張額外影象,並打上了偽標籤,將額外影象加入了原有的訓練集。首先,使用 AdamW 優化器對帶有預訓練的移動端模型 (表 3) 在新訓練集上進行微調。接下來,對模型主幹進行解凍,繼續對模型進行微調。最後,再次凍結模型主幹,並使用 SGDW 優化器對模型進行了額外的微調。

表 3. ByteScene 使用的移動端模型結構。

在第三次微調中,訓練影象被直接縮小為 128×128 解析度。最終的 INT8 量化 TFLite 模型是使用標準 TensorFlow 訓練後量化工具轉換得到的。為了保持量化後的模型精度,團隊在移動端模型中僅使用了 ReLU6 和 HardSigmoid 這兩種非線性啟用函數。

演算法的應用

目前,視訊內容是大眾消費內容的很核心的一部分(抖音、TikTok 等),但剪輯視訊對於大眾使用者來講,依然屬於比較複雜的資訊處理手段。對於大眾使用者來講,「想剪一個高質量的視訊」和 「剪輯技能的高門檻」 之間往往存在落差。智慧模板匹配為大眾使用者提供了一個低門檻的快捷視訊創作方式,真正實現了「一鍵成片」(如下圖)。影象場景檢測 / 分類演算法通過預測每張圖片素材的場景類別,為智慧模板匹配提供了重要的匹配依據。這項演算法,讓普通使用者也能通過簡單的操作,剪輯出高質量的視訊,有助於提升平臺的使用者體驗和黏性。

位元組跳動智慧創作團隊

智慧創作是位元組跳動的多媒體創新科技研究所和綜合型服務商。覆蓋音視訊、計算機視覺、語音、圖形影象、工程軟體開發等多技術方向,在部門內部實現了內容創作和消費的閉環。旨在以多種形式向公司內部各類業務線和外部 toB 合作伙伴提供業界最前沿的多媒體和智慧創作能力與行業解決方案。

目前,智慧創作團隊已通過位元組跳動旗下的智慧科技品牌火山引擎向企業開放技術能力和服務。

相關文章

機器之心釋出機器之心編輯部MAI(Mobile AI Workshop)是由 CVPR 主辦的 Workshop 競賽。近期,來自位元組跳動智慧創作團隊的 ByteScene 團隊在 MAI 2021 實時移動端場景檢測項目

2021-06-11 15:30:09

明敏 發自 凹非寺量子位 報道 | 公眾號 QbitAI你可能想不到,幾坨便便居然可以這麼有價值。最近,《Nature》發表了一篇關於古人類糞便的論文,為研究1型糖尿病、肥胖等疾病提供了

2021-06-11 15:29:58

iOS15 隱藏功能蘋果在推出 iOS15 之後,雖然釋出會上沒有說什麼太大的新功能,但是各路開發者都發掘到了不少隱藏的功能。在近日,又有開發者發現了 iOS15 版本隱藏了全新的 iPhon

2021-06-11 15:29:39

今日,realme在印度推出realme C25s新手機。該機搭載聯發科 Helio G85處理器,基於Android 11的realme UI 2.0,內建6000mAh的大容量電池。 同時,realme C25s配置6.5英寸、H

2021-06-11 15:29:18

作為「1+8+N」戰略中重要的終端之一,MagicBook系列筆記本自發布以來,不斷打破銷量紀錄,引領行業創新,備受市場和消費者的認可。5月初,MagicBook家族迎來了全新的X系列成員,新品承

2021-06-11 15:28:30

IT之家 6 月 11 日訊息 根據IT之家網友投稿,6 月 9 日奧林巴斯釋出了 OLYMPUS PEN E-P7 微單相機。該產品體積小巧,造型復古,延續了 PEN 系列的輕便設計。相機搭載 2030 萬畫素

2021-06-11 15:28:07