夢晨 博雯 發自 凹非寺量子位 報道 | 公眾號 QbitAI曾有一位北大碩士生,在校期間一次性在國際頂會ACL中標8篇論文,其中2篇一作,還登上了知乎熱搜。在那次熱搜之後,這位「論文大

2021-06-24 23:11:33

夢晨 博雯 發自 凹非寺量子位 報道 | 公眾號 QbitAI

曾有一位北大碩士生,在校期間一次性在國際頂會ACL中標8篇論文,其中2篇一作,還登上了知乎熱搜。

在那次熱搜之後,這位「論文大戶」似乎逐漸銷聲匿跡。

今天,她帶著阿里達摩院深度語言模型體系AliceMind回來了。

這位被外界稱為「AI蘿莉」的羅福莉,就負責這次AliceMind中7個模型的開源。

她的經歷說起來有點「傳奇」。

上大學之前沒怎麼接觸過電腦,卻誤打誤撞進了北師大計算機專業。

剛入學時因沒有基礎成績墊底,靠著努力躍升到前一、二名。

大三時進入北大語言計算實驗室實習,選擇了NLP作為自己的科研方向,在3個月內自學Python並投出一篇頂會論文(非一作)。

保研進入北大,碩士兩年間在國際頂會上發表了超過20篇論文。

但她出人意料地沒有選擇繼續讀博,而是在2020年畢業之後就加入了阿里達摩院,想做點實在的研究。

進入工業界這兩年,她發的論文明顯減少了。

在讀書的時候,周圍的評價機制都是非常在意你的論文數量。但是到工業界,我現在已經不追求數量了,主要是追求做這個工作是不是真的有落地價值,是不是在這個領域有一些影響力。

她在達摩院主導開發了跨語言預訓練模型VECO,成為AliceMind八大模型之一。這次AliceMind集體開源,她挑起了大梁。

簡單的才是最讚的

羅福莉在業界工作這一年,與在學術界時相比心態上有了很大的轉變:

在學校的時候總是追求提出一個很複雜的模型,大家看不懂,論文評審人也看不懂,但是到工業界的時候就會發現一眼就能看懂並且還有效的模型才是最讚的。

這也是她所在的達摩院深度語言模型團隊的思路,他們打造的AliceMind八大模型先後登頂了GLUE、CLUE、XTREME、VQA Challenge、DocVQA、MS MARCO六大NLP權威榜單。

AliceMind中Alice的含義其實很簡單,就是Alibaba’s Collection of Encoder-decoders。

其中的模型也像這個名字一樣樸實,都是從實際業務需要出發,在Encoder-decoder的基礎上進行創新和改進。

通用語言模型StructBERT,在BERT的基礎上增加了詞級別和句級別的兩個新目標函數,相當於讓AI掌握了「漢字序順不響影讀閱」這個能力。

這是因為團隊在阿里的業務中發現,使用者在電商、娛樂產品等輕鬆地使用場景時,經常出現語法、語序不正確等現象。

這就需要讓語言模型在面對語序錯亂、語法不規範的詞句時,仍能準確理解並給出正確的表達和迴應。

AliceMind剛剛還再次登頂了多模態權威榜單VQA Challenge 2021。

VQA Challenge的比賽任務類似看圖問答,給定一張影象和關於影象的自然語言問題,AI需要提供準確的自然語言答案。

對此,AliceMind的多模態模型StructVBERT,在通用模型StructBERT的基礎上,同時引入文字和影象模態。

利用更高效的視覺特徵和創新的交叉注意力機制,在統一的多模態語義空間進行聯合建模。

除了跨模態,羅福莉主導的跨語言模型VECO也被頂會ACL2021錄用。

VECO中也引入了交叉注意力機制,改變了以往跨語言資訊在隱藏層中自動建模的不穩定性,而是「顯式」地完成。

VECO的另一項創新是在預訓練的過程中,充分學習用於語言理解(NLU)和生成(NLG)任務,並讓二者互相學習提高彼此。

如今羅福莉再回顧VECO這個工作,也有一些感慨:

如果是兩年前還在學校的我,會覺得這好簡單,我可以加上很多的花式技巧。但是到了工業界要考慮到架構在不同業務場景下的通用性,只好犧牲一些複雜有趣的模型設計。

AliceMind中的生成式語言模型PALM,則是將預訓練目標從重構輸入文字,改成了預測後續文字。

這樣一個改動就促使模型對輸入文字進行更深入地理解,在問答生成、文字複述、回覆生成、文字摘要等任務上都取得了更好的效果。

還有結構化語言模型StructuralLM、機器閱讀理解模型UED和知識驅動的語言模型LatticeBERT,都在各自的領域取得了明顯地優勢。

除了此次開源的7個模型,AliceMind中還包括了超大規模中文理解和生成統一模型PLUG。

AliceMind中的模型,看起來有一個共同特點,就是擅長」跨界「。

從跨語言、跨模態到語言理解和生成的統一,都是基於Transformer架構將不同地輸入在一個更大的編碼空間上統一建模。

羅福莉補充道:

AliceMind的這種將Transformer作為統一模型架構的解決方案已經比較成熟,但要做到更好「跨界」,接下來努力的方向是解決不同類型或粒度輸入的深度融合和匹配問題。

從基礎模型擴展出能力多樣的模型,再把它們在實際業務中結合使用,讓AliceMind成了業界能力最全面的深度語言模型體系。

那麼AliceMind都用到了哪些地方?

落地是個系統化的工程

AliceMind已經上線到阿里內部的NLP平臺,可以提供給不同部門的業務使用。

在官方網站上也提供了Demo,比如這個基於PLUG模型的語言生成模組。

輸入紅樓夢選段:

就能生成一段續寫:

而像這樣可供大家試玩的Demo還有幾十個。

不過這些官網上的服務並非都是由AliceMind提供技術支援,很多都只是這一體系啟發下的小模型。

那麼這次開源的幾大核心目前都在哪裡打工呢?

應用最廣泛的,就是電商。

尤其是阿里巴巴國際事業部(ICBU)或像速賣通(AliExpress)這樣擁有跨境電商業務的部門,就是多語言模型VECO的直接受益者。

VECO是AliceMind體系中的8大模型之一,用於多語言理解和跨語種的文字嵌入、分類,掌握了100多種語言。

阿里內部基於AliceMind的翻譯平臺日呼叫量約10億次,創造了數億美元的國際跨境貿易和其他國際業務商業價值。

就像達摩院深度語言模型團隊負責人黃鬆芳所說「語言模型落地是個系統化的工程」:

語言模型從訓練、微調到蒸餾、壓縮,到整個部署上線都在平臺上面完成,上線之後跟業務方的系統連在一起,能夠直接嵌到他們的業務邏輯、業務系統裡面去。

我們更熟悉的淘寶拍照識圖、天貓精靈智慧音箱中也有AliceMind的貢獻。

目前,AliceMind已經在阿里內部數十個核心業務落地,日均呼叫50億次,活躍場景超過200個。

在阿里之外,醫療領域尤其是癌症治療上,AliceMind同樣出力不少。

作為一個具有自主學習能力的深度學習語言模型體系,AliceMind應用在搜尋引擎上時會有一個重排機制。

以具體某一類醫學文獻為目標,AliceMind在粗排先撈了一批相關文字後,還會再次結合文章類型、引用圖譜等資訊,進行不斷地重排。

同時將抽取獲得的資訊與已知的結構化知識做融合,構建知識體系,最終得到最高質量的臨床文獻。

在最近16支世界知名團隊參加的精準醫學國際評測中,憑藉這一精準醫學搜尋引擎,阿里團隊在兩項臨床證據質量評估上均取得第一:

這樣高精度的專業醫學搜尋引擎能夠在疾病治療時,為臨床醫生做提供高質量的臨床決策輔助。

法律領域也有AliceMind的出沒。

浙江省高階人民法院就與達摩院合作,實現了從立案到裁判文書生成的全流程智慧化審判系統。

而在這一試點單位中,AI對法官工作量的分擔使當庭宣判率提升至90%,結案時間也從平均40天縮短到50分鐘。

現在,基於AliceMind的AliNLP平臺日均累計呼叫量超過數萬億次,每天有超過每天有超過1000個業務方使用。

電商、教育、醫療、能源,通訊、法律、內容搜尋、城市大腦……越來越多的領域在AliceMind的加入下變得更加便利,更加智慧。

開源之後要做什麼?

現在,預訓練語言模型目前在NLP領域以及整個學習界都非常熱門,超大規模參數的模型已成為一種趨勢。

對此,達摩院深度語言模型團隊的負責人,也是AliceMind的總負責人黃鬆芳表示:

我們這邊其實不會一味地追求大,而是非常強調它的落地。

一個語言模型從研究開發到投入實際應用,不是一家企業就能做到的。

還需要整個社群的開發者都參與,才有可能將學術論文中的公式演算法用到大家的生活便利上。

達摩院希望通過開源,能降低業界研究和創新應用的門檻,使語言AI進入大工業時代。

下一步,AliceMind打算與語言學、神經科學等跨學科的單位加強合作,將語言AI擴展到更大的應用中。

開源地址:https://github.com/alibaba/AliceMind

AliceMind官網:https://nlp.aliyun.com/portal#/alice

相關論文:

通用預訓練模型StructBERT:https://arxiv.org/abs/1908.04577

多語言預訓練模型VECO:https://arxiv.org/abs/2010.16046

生成式預訓練模型PALM:https://arxiv.org/abs/2004.07159

多模態預訓練模型E2E-VLP:https://arxiv.org/abs/2106.01804

結構化預訓練模型StructuralLM:https://arxiv.org/abs/2105.11210

閱讀理解模型:https://ojs.aaai.org/index.php/AAAI/article/view/16584

融合知識的預訓練模型Lattice-BERT:https://arxiv.org/abs/2104.07204

參考連結:[1]https://mp.weixin.qq.com/s/LTVVOOhezUN96MRLrqKCAQ[2]https://mp.weixin.qq.com/s/PW0wZbts6ZpbKZSHyp8aVw

相關文章

夢晨 博雯 發自 凹非寺量子位 報道 | 公眾號 QbitAI曾有一位北大碩士生,在校期間一次性在國際頂會ACL中標8篇論文,其中2篇一作,還登上了知乎熱搜。在那次熱搜之後,這位「論文大

2021-06-24 23:11:33

Thermaltake(曜越)宣佈推出新款Toughpower TF1 1550 W Titanium-TT Premium Edition電源,這是一款高階電源,額定功率為1550W,是專門為超鎖的愛好者設計的產品,得到80 Plus鈦金認證

2021-06-24 23:10:57

繼6月16日,國際巨頭三星電子宣佈,聯合加州大學聖巴巴拉分校的研究人員完成首個6G原型系統的測試並進行公開演示後,韓國又有關於6G的新動作。6月23日36氪訊息,為了押寶6G技術,韓國

2021-06-24 23:10:23

各大機構的資料顯示,蘋果公司在2020年賣出了1.9億部到2億部智慧手機,這個資料並不是蘋果的最高水平;實際上,相比蘋果公司的最高水平,這個銷量還是下滑的;當然受到疫情影響和晶片供

2021-06-24 22:51:18

全球頂級的計算機視覺及人工智慧會議CVPR 2021落下帷幕,OPPO在六大賽道共十二項賽項中取得一項第一,七項第二,四項第三的優異成績,僅次於百度等國內第一梯隊的參賽選手。據瞭解,

2021-06-24 22:51:03

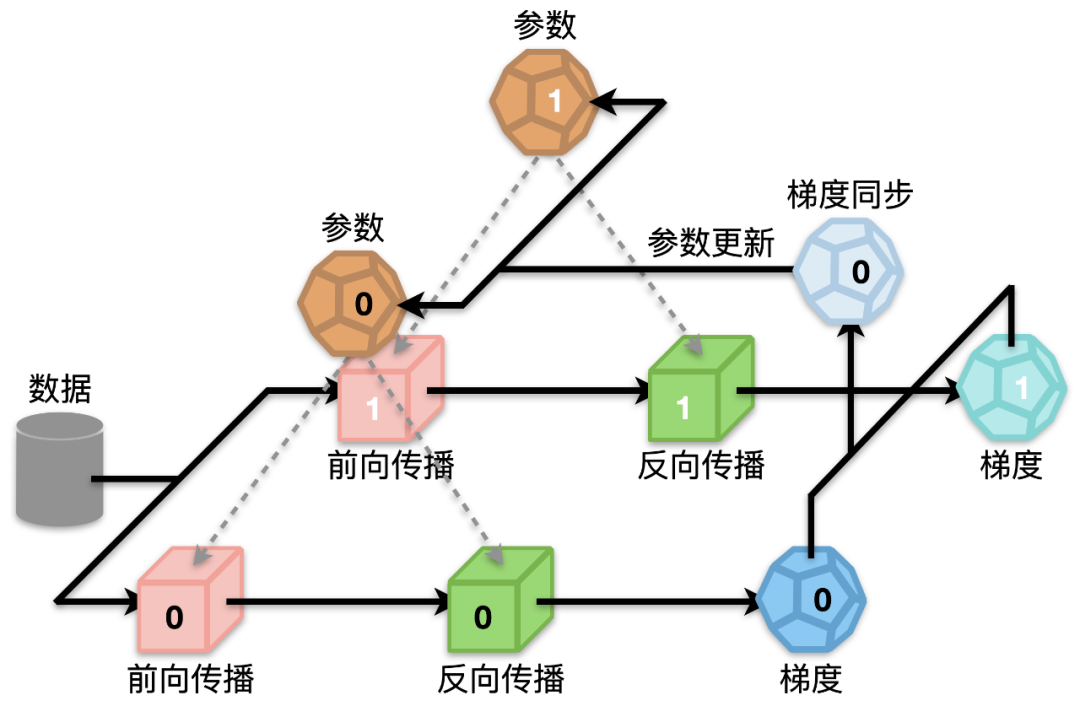

機器之心專欄機器之心編輯部Transformer 已經成為眾多 NLP 任務以及部分 CV 任務的主流模型,但由於硬體資源匱乏,很多高校實驗室或者公司都無法訓練很大的模型,而降低批處理大

2021-06-24 22:49:29