近年來,由於視訊理解成為實現 VR/AR 以及視訊共享社交網路服務等實際應用的關鍵元件,學術界對該領域的研究越來越感興趣。每天有數百萬個視訊上傳到 TikTok、抖音和西瓜視訊進

2021-06-01 23:11:12

近年來,由於視訊理解成為實現 VR/AR 以及視訊共享社交網路服務等實際應用的關鍵元件,學術界對該領域的研究越來越感興趣。每天有數百萬個視訊上傳到 TikTok、抖音和西瓜視訊進行處理。但是,視訊流的爆炸式增長對執行視訊理解所需的高準確率和低計算成本提出了挑戰。

作為視訊理解的一個基本問題,動作識別在內容稽核和推薦等視訊相關的應用中被提出了越來越高的要求。隨著 VR 等技術的飛速發展,與時序相關的動作識別也成為了近年來的研究熱點。

時空性、特徵和運動模式是視訊動作識別任務的重要組成部分。目前,學界主流方法普遍採用基於卷積神經網路(CNN)的 2D 和 3D 框架。其中,2D CNN 計算成本較低但無法捕獲時態關係,3D CNN 在時空建模任務中有效但計算成本較高。

來自愛爾蘭都柏林聖三一學院和位元組跳動 AI 實驗室的研究者提出了一種時空激勵( Spatio-Temporal Excitation, STE)模組、通道激勵( Channel Excitation, CE)模組和運動激勵(Motion Excitation, ME)模組三者合一的輕量級高效 Action 模組,並將該模組移入到 2D CNN 中得到 Action-Net,在多個基準資料集上實現了不錯的效能。

在機器之心最新一期 CVPR 2021 論文線上分享中,我們邀請到了論文一作、都柏林聖三一大學博士後研究員王正蔚為大家介紹 Action 模組和 Action-Net 框架的技術細節。

歡迎大家報名參與,如有疑問可在 QA 環節與分享嘉賓交流。

分享主題:即插即用的多路徑激勵動作識別模組 ACTION

嘉賓簡介:王正蔚,都柏林聖三一大學博士後研究員,目前主要研究視訊動作識別,側重於人機互動、VR/AR 等時序動作的應用場景。

分享摘要:本文由位元組跳動研究員佘琪和都柏林聖三一大學王正蔚合作完成,關注高效視訊特徵學習。視訊應用場景近幾年變得越來越多元化比如視訊分類、視訊精彩時刻挖掘和人機互動。在此工作中,主要側重於時序動作識別比如人機互動與 VR /AR 中的手勢識別。和傳統的動作識別相比如 Kinetics(注重視訊分類),此類應用場景主要有兩種區別:其一是 一般部署在邊緣裝置上如手機和 VR / AR 裝置上,所以對模型計算量和推理速度有一定的要求;其二此類動作(「Rotate fists counterclockwise」vs「Rotate fists clockwise」)和傳統動作識別動作(「Walking」vs「Running」)相比有著較強時序性。針對以上的兩點,基於 2D CNN(輕便)提出了一個混合注意力機制的 ACTION 模組(對於時序動作建模)。

論文連結:https://arxiv.org/pdf/2103.07372.pdf

時間:北京時間 6 月 4 日 19:00-20:00直播間:https://jmq.h5.xeknow.com/s/2navB

直播交流群:歡迎大家入群交流,後續 CVPR 2021 線上分享也將在群中同步預告。

如群已超出人數限制,新增小助手:syncedai2、syncedai3、syncedai4 或 syncedai5,備註「CVPR」即可加入。

CVPR 2021 線下論文分享會

除了線上分享,機器之心將於 6 月 12 日組織「CVPR 2021 線下論文分享會」線下學術交流活動,更好的服務 AI 社群,促進國內計算機視覺學術交流。

時間:6 月 12 日 9:00-18:00地址:北京市望京凱悅酒店

本場論文分享會將設定 Keynote、 論文分享和 Poster 環節,邀請頂級專家、論文作者與現場參會觀眾共同交流。部分日程如下,歡迎大家積極報名學習。

相關文章

近年來,由於視訊理解成為實現 VR/AR 以及視訊共享社交網路服務等實際應用的關鍵元件,學術界對該領域的研究越來越感興趣。每天有數百萬個視訊上傳到 TikTok、抖音和西瓜視訊進

2021-06-01 23:11:12

日前,TrendForce公佈的資料顯示,在2021年第一季度,全球前十大晶圓代工廠中,聯電擠掉美國格芯,坐上了全球第三的位置。成立於1980年的聯電,並在1995年時轉型為晶圓代工廠,是中國臺灣

2021-06-01 23:10:19

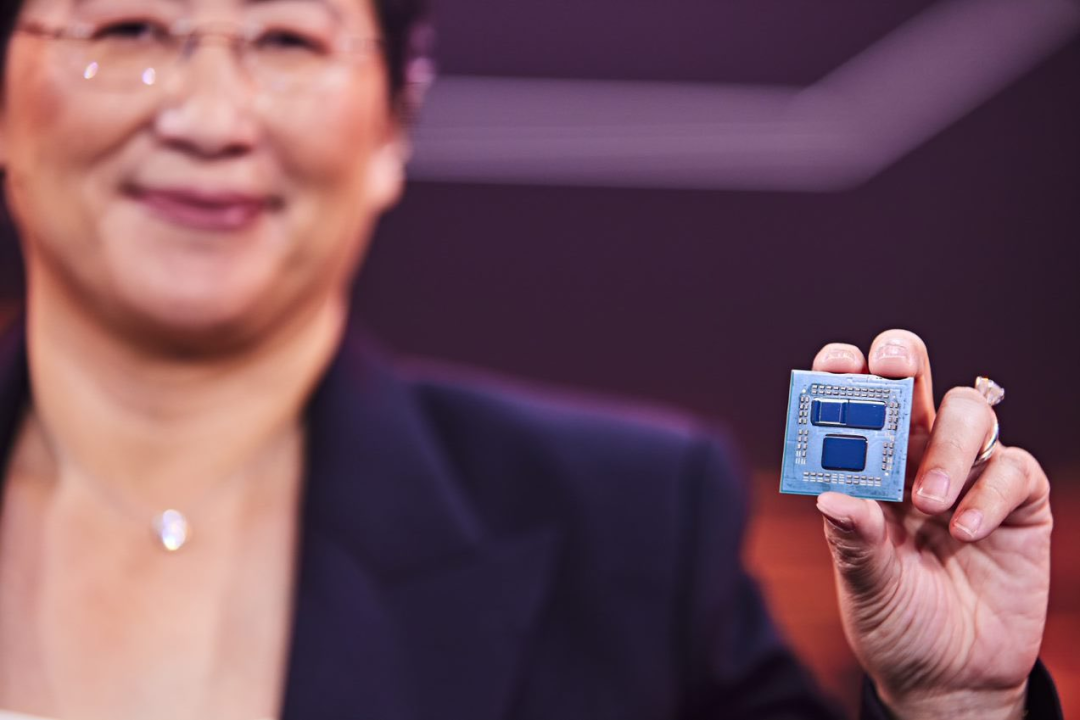

機器之心報道編輯:澤南、小舟FSR 將適用於 GTX 10 系列至今以來的所有顯示卡,是的你沒看錯,支援英偉達的顯示卡。剛剛在臺北 ComputeX 展會上,AMD 原本被認為日常走過場的主題演

2021-06-01 22:49:20

6月1日凌晨,618大促正式開啟,不少手機品牌都取得開門紅,小米官方更是直接公佈了戰報。根據官方公佈的資料,在開售近50分鐘後,全平臺支付金額突破15億。而於6月1日凌晨首銷的紅米N

2021-06-01 22:48:26

在高階手機領域,驍龍888、驍龍870手機的出現,激發了廣大消費者的購買慾望。但是現階段的新機實在是太多了,儘管旗艦手機的數量大幅度增加,但對於消費者來說,永遠是下一款新機更加

2021-06-01 22:48:14

黑的、白的、粉的、灰的…各種顏色的機械鍵盤在當下早已見怪不怪,各種炫目的RGB燈效時間久了也會讓人審美疲勞。同時,伴隨著使用者群體需求的變化,可DIY的電子數碼產品,正被越來

2021-06-01 22:28:24