經過60餘年的發展,人們已經研發了各種各樣自然語言處理技術,這些紛繁複雜的技術本質上都是在試圖回答一個問題:語義在計算機內部是如何表示的?根據表示方法的不同,自然語言處理技

2021-08-17 03:03:56

直播提問,參與抽書

在本次直播過程中,我們將從所有在直播間評論區提問的小夥伴中隨機抽出10位送出《自然語言處理:基於預訓練模型的方法》。

第1部分:基礎知識。包括第2~4 章,主要介紹自然語言處理和深度學習的基礎知識、基本工具集和常用資料集。

本次贈書由博文視點提供。博文視點( Broadview )是電子工業出版社下屬旗艦級子公司。在IT出版領域打磨多年,以敏銳眼光、獨特視角密切關注技術發展趨勢及變化,致力於將技術大師之優秀思想、一線專家之一流經驗集結成書,為眾多愛學習的小夥伴奉獻精誠佳作,助力個人、團隊成長。

相關文章

經過60餘年的發展,人們已經研發了各種各樣自然語言處理技術,這些紛繁複雜的技術本質上都是在試圖回答一個問題:語義在計算機內部是如何表示的?根據表示方法的不同,自然語言處理技

2021-08-17 03:03:56

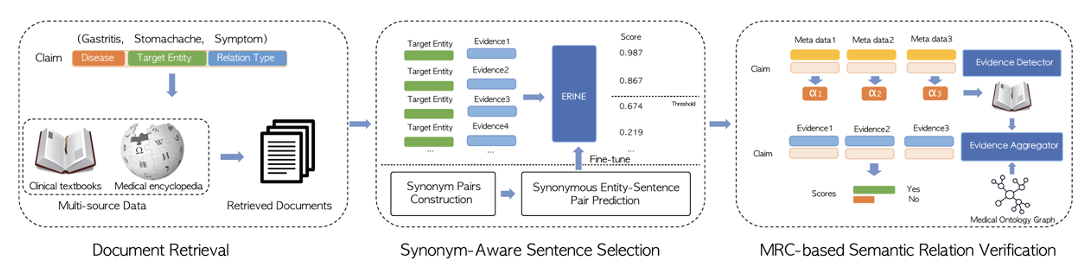

8月14日至18日,國際資料探勘與知識發現大會 KDD 2021在線上正式舉行。此前本屆KDD入選論文已經揭曉,百度被收錄的多篇論文,其突出的特點是學術研究與技術應用緊密結合,再次展現

2021-08-17 03:03:46

在之前文章中已經寫過了,自學程式設計有兩個必要條件=邏輯思維+程式設計英語。有關沒有學歷的普通人是否可以通過自學程式設計月入過萬,這邊有幾點建議: 如果學歷不到專科,那麼

2021-08-17 03:03:27

我們在做短視訊的路上總是有很多問題,例如怎麼突破播放量,短視訊還有沒有機會等等。所以今天就收集了各大網站上以及大家平時比較多的問題給大家做一個合集。01 實操問題1. 怎

2021-08-17 03:03:21

自從 iOS 系統自帶了電池健康度檢視之後,有不少使用者都會有意無意的觀察一下自己的電池健康度,每當看到健康度掉了 1% 就會非常難受。而根據蘋果的說法,當裝置的健康度掉下 80

2021-08-17 03:03:17

華為手機近期釋出了華為P50系列高階機,售價不便宜,產品配置確實很重磅,只是全系均為4G版本,並沒有5G版本,這讓人有點遺憾了,畢竟華為是最先推出雙模5G手機的品牌,曾經走在行業的前

2021-08-17 03:03:09